自製 語音辨識的問題,我們搜遍了碩博士論文和台灣出版的書籍,推薦施威銘研究室寫的 Flag’s 創客‧自造者工作坊 用 AI 影像辨識學機器學習 和施威銘研究室的 Flag’s 創客‧自造者工作坊 超入門!AI 聲音姿態影像辨識大應用都 可以從中找到所需的評價。

另外網站Speech-to-Text:自動語音辨識也說明:您可以透過採用Google AI 研究和技術精華的API,將語音準確轉換為文字。 新客戶可以獲得價值$300 美元的免費抵免額,盡情體驗Speech-to-Text。

這兩本書分別來自旗標 和旗標所出版 。

亞洲大學 資訊傳播學系 陸清達所指導 王亮瑜的 使用深度學習神經網路實現具有語者辨識之會議記錄生成系統 (2021),提出自製 語音辨識關鍵因素是什麼,來自於深度學習神經網路、遷移式學習、語者辨識、語音辨識、關鍵辭檢測。

而第二篇論文國立虎尾科技大學 資訊工程系碩士班 陳國益所指導 叢鴻日的 用於虛擬佈展與互動導覽之混合實境全自動物品替換影像辨識演算法 (2020),提出因為有 三維重建、影像辨識、虛擬實境、擴增實境、ARCore、虛實物品替換演算法、鏡面反射、手部辨識、語音互動、Android、數位轉型、新冠肺炎的重點而找出了 自製 語音辨識的解答。

最後網站google智慧音箱推薦嗎?智慧家電&智慧音箱網友口碑看這裡!則補充:利用語音辨識技術,讓使用者不必碰觸按鈕介面,用聲音指令就能實現遠端 ... 或夜燈模式,甚至顯示出自製手繪圖案,是兼具實用與氣氛玩心的獨到選擇。

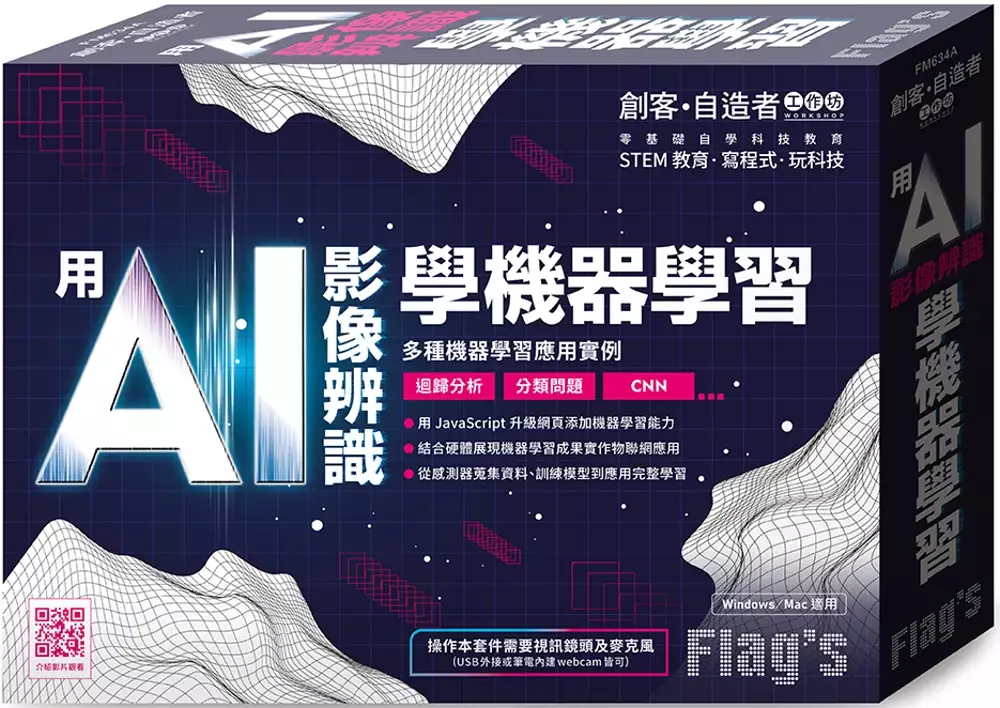

Flag’s 創客‧自造者工作坊 用 AI 影像辨識學機器學習

為了解決自製 語音辨識 的問題,作者施威銘研究室 這樣論述:

不同於常見機器學習皆是由 Python 語言實作, 本書使用 JavaScript 語言於瀏覽器實作機器學習, 搭配著名的 JS 機器學習函式庫 ml5.js 可以更快速且便利地達成 AI 網頁應用, 對於許多熟悉 JS 語言的前端工程師或使用者更為親近, 實驗過程使用 p5.js 程式庫, 讓沒有太多程式設計基礎的使用者也可以更輕鬆將結果視覺化, 再搭配使用 p5.js web editor 線上開發環境, 只需要使用瀏覽器就可以開始輕鬆設計網頁, 不需要在自己的主機建構繁瑣的開發環境, 再搭配 Python 編寫控制板程式, 將應用結合至感測器或實體輸出裝置, 實現更完整的機器學習

應用實例。 本書一開始會先介紹機器學習概念與 p5.js web editor 線上開發環境基本操作, 接著直接體驗使用 ml5.js 中的現有模型, 實作可以辨識特定物件的影像分類器。 除了網頁實作神經網路外, 可再串連硬體控制板, 藉由控制板輸出預測結果, 比如使用物件偵測來判斷是否有人出現, 對應的 OLED 顯示器模組就會出現迎賓文字或相關訊息;或是語音辨識讓玩家用語音來控制遊戲, 遊戲結束後會通知控制板啟動振動馬達回饋給玩家。 最後會使用 ml5 程式庫實際訓練自己的神經網路模型, 首先為利用控制板蒐集感測器資料, 再透過神經網路訓練解決迴歸問題, 如藉由溫度

感測器的訊號, 找出感測值與實際溫度的關係, 做出自製即時電子溫度計, 再結合可以即時顯示畫面去背效果的 U-Net 模型, 就可以使用環境溫度來改變虛擬背景特效。 接著為解決分類問題的神經網路, 使用現成的 Facemesh 模型找出臉部特徵點, 分別蒐集臉部不同的角度資料進行訓練, 最終得到一個可以辨識是否打瞌睡的模型, 再串接實體蜂鳴器在打瞌睡時, 發出警報聲提醒使用者。 最後訓練的神經網路為卷積神經網路, 透過蒐集配戴口罩與否的不同照片作為訓練資料, 經過卷積神經網路訓練後, 就可以用此模型來判斷畫面中的人是否有正確配戴口罩, 再結合模擬門鎖的伺服馬達, 建構出一套口罩

門禁系統的概念。 本產品除實驗手冊外,實驗過程中有任何問題或是建議都可以在 Facebook 粉絲專頁《旗標創客‧自造者工作坊》中留言,即有專人為您服務。 本產品 Windows / Mac 皆適用 操作本產品需要視訊鏡頭及麥克風 (筆電內建或 USB 外接 webcam 皆可) 本書特色 ● 用 JavaScript 升級網頁添加機器學習能力 ● 結合硬體展現機器學習成果實作物聯網應用 ● 從感測器蒐集資料、訓練模型到應用完整學習

使用深度學習神經網路實現具有語者辨識之會議記錄生成系統

為了解決自製 語音辨識 的問題,作者王亮瑜 這樣論述:

會議紀錄的工作需要在快速進行的議程中,同時分辨說話者身分與說話內容,並且正確的記錄內容是十分沉重而繁雜的工作;會議進行中也經常出現與會者雖然出席,但卻不知道討論內容是什麼狀況;大型會議主持人與出席人員也可能不知道發言的人是誰,或聽不清楚發言的內容。本文的目的在於開發一項自動產生會議記錄的系統,自動將會議內容轉換為文字記錄,減少會議紀錄的記錄時間與人力成本,並找出會議中的關鍵辭,讓與會者能快速地了解會議主題與方向,避免發生文不對題的狀況。本文系統包含三部分:中文語者辨識(speaker identification)、語音辨識(speech recognition)、與關鍵辭辨識。在語者辨識的

部份透過使用遷移式學習(transfer learning)以自製語料庫訓練YAMNet卷積神經網路(Convolutional Neural Network, CNN)辨識說話的語者;語音辨識使用Google- Speech- to- text API將語音資料轉換為文字。最後把語者及語音辨識結果同時顯示出來,達到自動產生會議紀錄的功能。在關鍵辭辨識使用 Jieba 中文斷詞工具,以先前辨識的文字紀錄為基礎,偵測出現頻率較高的字詞當作關鍵辭,讓與會者即時掌握目前會議的重點。實驗結果證明本文方法可以準確的辨識中文語者的身分,同時也能正確的辨識出不同講者說話的內容,完成會議記錄與辨識語音中的關鍵

辭。

Flag’s 創客‧自造者工作坊 超入門!AI 聲音姿態影像辨識大應用

為了解決自製 語音辨識 的問題,作者施威銘研究室 這樣論述:

實作 AI 的門檻已逐漸降低, 也不再是專業研究人員才能觸碰的領域, 本套件排除了需要具備專業知識與能力才能實作 AI 應用的障礙, 直接應用既有的機器學習服務 Teachable Machine, 僅需要簡單幾步驟即可訓練自己的分類器模型, 再利用網路服務來橋接開發板及各項硬體, 便利且迅速完成各種應用及實驗。 本產品會帶領讀者使用 Teachable Machine 服務一步步來建立自己的機器學習模型, 內容囊括『聲音辨識』、『姿態辨識』以及『影像辨識』三類, 完成模型後再匯入到我們已經準備好的應用網頁, 直接實現 AI 辨識實作應用, 例如先建立不同表情分類

, 再根據分類拍攝相對應的表情樣本, 經過訓練後即可得到分類自己表情的模型, 匯入預先準備好的實驗網頁, 即完成了透過網頁和 webcam 來辨識心情的分類器, 接著學習 Python 程式語言讓開發板取得網頁辨識結果, 再根據結果控制硬體, 如 LED 條燈, 就可以將使用者的心情透過 LED 燈不同的特效來表現, 若將配戴口罩與否的照片訓練後做成分類器, 再搭配蜂鳴器發出警示音, 即可完成口罩偵測警報系統;搭配 IFTTT 物聯網服務還可以做成只有特定的人物才能讀取 LINE 訊息。 另外還有聲音辨識可以訓練成自己專屬的台語小老師, 隨機出題考考你, 答對了就會放音樂;聲控心情特效燈

, 只要說出你的心情, 就可以切換氣氛 LED 燈!姿態辨識鬧鐘讓你設定起床的時間到, 一定要起身對著鏡頭做出特定動作才能解除!若將自己不熟練的瑜珈動作製作成模型, 搭配網頁立刻就變成了瑜伽小老師, 隨機出題陪你不斷練習~ 還有不需自己訓練模型也可以實現的語音辨識 API, 只要念出音樂簡譜上的數字, 就可以讓蜂鳴器幫你唱出正確的音調, 豐富多樣的 AI 實作且不用先學會 AI。 本產品除實驗手冊外,實驗過程中有任何問題或是建議都可以在 Facebook 粉絲專頁《旗標創客‧自造者工作坊》中留言,即有專人為您服務。 本產品 Windows / Mac 皆適用 操作本產品

需要視訊鏡頭 (筆電內建或 USB 外接 webcam 皆可) 本書特色 ● 實作 AI 不用先會 AI ● 簡單步驟就可以訓練自己的模型 ● 模型上傳雲端使用超便利 ● 機器學習概念超入門 ● AI 入門必學 Python 語言 ● AI 辨識整合硬體大應用 ● AI 聲音辨識 ● AI 姿態辨識 ● AI 影像辨識 組裝產品料件: D1 mini 相容控制板 × 1 片 全彩 RGB LED 燈條 × 1 條 Micro-USB 傳輸線 × 1 條 公對公杜邦線 × 1 排 無源蜂鳴器 × 1 個 麵包板 × 1 片

用於虛擬佈展與互動導覽之混合實境全自動物品替換影像辨識演算法

為了解決自製 語音辨識 的問題,作者叢鴻日 這樣論述:

近年來因應新冠肺炎的影響,全球各地開始限制外出,嚴重地方甚至封城,這導致許多公共展覽空間,例如:博物館和美術館展覽,紛紛被迫停止或延期。同時在疫情的影響下,民眾外出參與藝文活動的意願大幅降低,這也使得許多國家的博物館和美術館開始進行數位轉型,其目的在於避免人與人之間密切的接觸,進而導致疫情擴散,且藉由數位媒體的傳播,更能吸引到新的客群以及合作,達到知識資產分享之目的。本研究希望讓使用者在不出門的情況下,能夠自由的在家中進行佈展與參觀,同時以身邊常見之設備進行混合實境體驗,因此本研究選擇手機作為開發平台。考慮到傳統頭戴式裝置其採用魚眼鏡片進行變形成像,導致畫面有所變形不真實,於是本研究自行開發

頭戴式裝置,使用者只須將手機放入自製之頭戴式裝置內,便能透過鏡面反射(Specular Reflection)原理體驗混合實境的觀展效果。在本研究中,透過 Google ARCore 函式庫,可以得知使用者當前所在位置,與現實空間中環境樣貌,並使用單點雷射掃描系統對欲替換之現實物體進行掃描,以便實現虛實物體替換功能,並藉由自動縮放與矯正系統,使虛擬物體能夠覆蓋住現實物體。為了讓使用者能夠更隨心所欲地進行佈展,本研究另外設計出透過手指位置與即時語音指令,便可進行佈展的物體建置系統,基於 OpenCV 函式庫和顏色通道轉換演算法,達到捕捉使用者手部之效果,透過混合實境中的環境感知技術,讓使用者可以

憑藉著手指與語音指令,自由地將虛擬物品建置於現實場景中。同時為了讓使用者可以與虛擬物體進行互動,本研究基於 Android Studio 的 GoogleTranslate 函式庫,開發連續性背景是語音對話系統,讓使用者可透過語音的方式,與虛擬導覽員互動導覽和參觀佈展,藉以到無須出門就能體驗參觀博物館之混合實境體驗。

自製 語音辨識的網路口碑排行榜

-

#1.Maker出張嘴!打造智慧語音助理工作坊

身兼數職,渴望語音助理來相助,同時也想動手自製一台的 Maker。 ... 把玩開發人員專屬SDK、API來得到Google Assistant強大語音辨識能力。 組裝完畢後,實際演練如何將 ... 於 www.accupass.com -

#2.深度學習: 語音識別技術實踐

書名:深度學習: 語音識別技術實踐,ISBN:7302516928,作者:柳若邊,出版社:清華大學,出版日期:2019-04-01,分類:DeepLearning. 於 www.tenlong.com.tw -

#3.Speech-to-Text:自動語音辨識

您可以透過採用Google AI 研究和技術精華的API,將語音準確轉換為文字。 新客戶可以獲得價值$300 美元的免費抵免額,盡情體驗Speech-to-Text。 於 cloud.google.com -

#4.google智慧音箱推薦嗎?智慧家電&智慧音箱網友口碑看這裡!

利用語音辨識技術,讓使用者不必碰觸按鈕介面,用聲音指令就能實現遠端 ... 或夜燈模式,甚至顯示出自製手繪圖案,是兼具實用與氣氛玩心的獨到選擇。 於 www.housefeel.com.tw -

#5.ChatGPT AI人工智慧自然語言與語音語意辨識開發應用實務班 ...

ChatGPT AI人工智慧自然語言與語音語意辨識開發應用實務班(112.05.15-16) - 課程 ... 自製合成語音程式開發。語音轉檔案wave 。中文、英文語音輸入使用Google API 。 於 college.itri.org.tw -

#6.溫哥華聯合中文學校2023漢字平板輸入競賽

會中校長嘉勉學生們對中文學習的堅持與熱忱,此次中文活動的亮點是以校長自製APP融入拼音或語音辨識,將中文運用於生活中,深獲參賽學生們的喜愛,獲 ... 於 www.huayuworld.org -

#7.HomePod 15.6 更新,Siri 新增三種語言中文、粵語、日文

... 正式推出iOS 15.6、iPadOS 15.6 的更新,同時也發布HomePod 和HomePod mini 的audioOS 15.6 更新,主要更新內容為支援中文、日文的Siri 語音辨識。 於 applefans.today -

#8.AI 語音辨識

AI 語音辨識 ; ReSpeaker Mic Array v2.0.1(4麥克風聲學陣列) · ReSpeaker Mic Array v2.0.1(4麥克風聲學陣列). NT$2,050 ; 語音辨識模組(相容Arduino 樹莓派) · 語音辨識模組( ... 於 shop.playrobot.com -

#9.天氣預報AI 機器人

語音辨識 的部分(microbit) 則是使用python 來. 寫出程式。 語音輸出部分則是使用吉哥積木裡的程式庫搭. 配Arduino 編輯器來完成。 二、外觀. 於 gifted.ntpc.edu.tw -

#10.語音助理Archives

可嵌入Google Assistant 或是雲端語音辨識功能,例如Alexa等。 可串接snowboy 自訂喚醒詞,串接Dialogflow 自然語言理解平台。 適用所有版本樹莓派,Raspberry Pi Pi 4 ... 於 piepie.com.tw -

#11.Grove - Speech Recognizer 語音識別模組

這個語音識別器可以識別22個命令,包括“開始”,“停止”,“播放音樂”等。每次識別一個命令,它將返回一個值,然後連接到它的揚聲器將重複該命令。這個值可以用來控制其他 ... 於 www.taiwansensor.com.tw -

#12.雅婷逐字稿app

雅婷逐字稿App 即時語音輸入臺灣國語中英夾雜也聽的懂| 點子生… ... 智慧的開發團隊AILabs,推出了一款中文語音辨識App:「雅婷逐字稿」,在Android ... 於 atelierdesartssucres.fr -

#13.心得#蘭鐸- 簡單量身打造自己想要的過濾器更新至v3.22

... 尚未更新,所以新的辨識物品指令沒支援,但是勾選讓它顯示/隱藏是ok的) ... 改變(原本是塑界者神聖石語音),戰亂附魔培育器(頭盔)新增物等84+過濾. 於 forum.gamer.com.tw -

#14.AIQ智能語音聲控燈DIY幻彩燈組裝流程及實體延伸應用

活動七: 擴充語音模組以自訂指令控制燈號(AI聲控燈) 活動八: 透過擴充語音 ... 燈條與悟空板連接使用的杜邦線為母母(母母杜邦線附在語音辨識模組內) 於 www.oursteam.com.tw -

#15.AI語音平台引領生態系CES 2018成智慧家庭秀場| 新通訊

近來許多大大小小的廠商推出了各自不同的DIY居家系統產品,許多知名品牌也在CES 2018裡展示了它們的新概念或新系統。隨著晶片技術的創新與網路應用的演化 ... 於 www.2cm.com.tw -

#16.短影片製作:活用2 個工具,打造具備AI 語音與字幕的影片

FlexClip AI 搭配OpenAI Whisper(自動語音辨識,Automatic Speech Recognition,ASR)的優勢在哪裡?優勢在:【利用OpenAI Whisper 產生精準字幕後,再交棒給FlexClip ... 於 hipay0.com -

#17.動手DIY超簡單!TP-Link Tapo C420S2 智慧無線監控系統開箱 ...

產品的包裝盒如上,可以看到攝影機的樣貌,以及產品的特性(2K QHD 解析度、可全彩夜間錄影、防塵防水、支援Google 和Amazon 的語音助理..). 於 jazznews.com.tw -

#18.改善殘響環境中的自動語音辨識

關鍵字: 自動語音辨識,殘響去除,生成對抗模型,資料擴增,動態規劃, automatic speech recognition,dereverberation,GAN,data augmentation,dynamic programming,. 於 tdr.lib.ntu.edu.tw -

#19.Speechnotes線上語音轉文字軟體,聽聲音自動輸入內容。

前往Speechnotes Online網站後,先選擇要辨識的語言。 線上語音轉文字1. Ad. ▽接著按下麥克風講話,就會開始偵測聲音,並自動將語音輸出成文字囉。 於 www.pkstep.com -

#20.使用語音辨識進行文字聽寫

使用語音辨識進行文字聽寫. Windows 7 更多...更少. 您可以使用聲音,將文字聽寫到您的Windows 電腦。 例如,您可以聽寫文字來填寫線上表單;或者可以將文字聽寫到文書 ... 於 support.microsoft.com -

#21.LED 語音辨識動畫聲音主動式發光面罩USB 可充電 ...

GUANGXING LED 語音激活口罩USB 可充電聲音主動發光口罩適用於服裝聖誕 · 照明LED 面具發光LED 派對面具可程式化藍牙應用程式Diy 訊息LED. 於 www.amazon.com -

#22.【CyberPi】第十篇:人工智慧Say Hello 語音辨識講出世界 ...

使用人工智慧的語音辨識功能,來製作有趣的玩法,CyberPi板上集成麥克風功能,我們對者CyberPi 說出指定關鍵句,CyberPi判斷成功也回應您相關語句。 於 shop.mirotek.com.tw -

#23.ChatGPT教我如何簡易創建將聲音轉文字的語音辨識方法(含 ...

Python中有很多語音辨識庫可供選擇,例如Google Speech Recognition,Microsoft Bing Voice Recognition,CMU Sphinx等等。不同的庫有不同的優缺點, ... 於 vocus.cc -

#24.在「樹莓派」上玩兒轉語音識別,就這麼簡單!

谷歌AIY Voice Kit:可以DIY的人工智慧語音盒子 · 2018-07-03. 您可以使用Google智能助理構建獨立的語音識別系統,或者為基於RaspberryPi的項目 ... 於 kknews.cc -

#25.語音辨識APP專為台灣口音設計記錄更精準

AI技術當道,台灣人工智慧實驗室,推出全台首創、專為台灣口音開發的AI語音辨識,能夠即時記錄會議內容,無論國台語,甚至英日語都行,就算交錯使用 ... 於 www.ftvnews.com.tw -

#26.基於影像、聲音及手機感測資料融合的多模情緒辨識系統 ...

以自製資料集聲音部分測試聲音模型的各類情緒辨識準確度. ... 語音情緒辨識是透過人類聲音的語氣起伏、音調高低等特徵,來辨認潛在的情緒。 於 ntcuir.ntcu.edu.tw -

#27.Google Meet:線上視訊會議和通話

Google Meet 內建採用Google 語音辨識技術的即時字幕功能,可讓會議交流無障礙。無論是非母語人士、聽障與會者,或身處吵雜的咖啡店,即時字幕都能讓每位參與者輕鬆 ... 於 apps.google.com -

#28.Arduino探索漫遊車1—底盤最終組裝– 頁面3 – DevicePlus

... 機第2部分—具有語音辨識功能的餵食應用程式 · 自製Arduino RFID門鎖-第二部分:用智慧型手機解鎖 · TFT液晶面板與三軸加速度計的配合使用–第2部分. 於 micro.rohm.com -

#29.Xpark

新都會型水生公園2020/8/7與您見面. 於 www.xpark.com.tw -

#30.免付費SRT中文字幕快速生成工具,Mac也適用

編輯校對完就可以直接儲存發佈,這個流程對於YouTuber應該是最順暢的流程。 是說我總覺得Google之後應該也會加入這個自動生成字幕的功能,畢竟語音辨識 ... 於 jacksonlin.net -

#31.AIY Projects Voice Kit 將AI 嵌入Raspberry Pi $60 自製Google ...

Google 上月開放了Assistant API 給一般開發人,讓大家可以開發像Google Home 一樣具備語音辨識和人工智能的應用。最近Raspberry Pi 的官方專門 ... 於 www.pcmarket.com.hk -

#32.AIY Projects – Voice Kit 語音套件(v2.0),內含樹莓派Pi Zero ...

Google 和 Raspberry Pi 合作打造的AI 語音助理套件。 手把手教學與 Google Assistant SDK 範例程式。 可改成語音識別和自然語言處理。 於 ricelee.com -

#33.語音辨識- 人氣推薦- 2023年8月

語音辨識 網路推薦好評商品就在露天,超多商品可享折扣優惠和運費補助。 ... 421044"樹莓派WM8960音訊解碼模組智慧語音辨識雙麥克風智慧音箱DIY W7-201225 [42104. 於 www.ruten.com.tw -

#34.語音模塊- 優惠推薦- 2023年8月

24小時出貨|錄音賀卡機芯感恩卡片耶誕生日表白語音播放自製創意禮品音樂模塊. $233 - $276. 已售出34. 中國大陸. JQ6500語音模塊MP3模塊MCU串口控制播報一對一5路控制 ... 於 shopee.tw -

#35.全球最便宜的AI概念股在台灣 - Anue鉅亨專題

原因在於,智慧音箱擁有連網能力和語音辨識,可實現語音助理功能,像是行事曆或即時 ... 目前機器人核心零組件皆為自製,包括伺服馬達;其實,台達電也已做出工具機的 ... 於 topics.cnyes.com -

#36.即時口譯機器人DIY(一) - CH.Tseng

從TTS與STT談起之前曾介紹過工研院的TTS Text-To-Speech文字轉語音技術, ... 此外,Google STT的辨識率也相當令人驚艷,只要字正腔圓、以正常速度 ... 於 chtseng.wordpress.com -

#37.太陽系最美行星本週達「衝」,天文館週末開放望遠鏡觀賞土星

... 日土星衝(圖片來源:台北市立天文科學教育館)土星以肉眼即可看見,天黑後自東方升起,為淡黃色的星點,是東方天空最亮的一顆星,很容易辨識,更. 於 www.travel.taipei -

#38.Gravity: 離線語言學習語音辨識模組for Arduino / Raspberry Pi ...

商品說明. Gravity: 離線語言學習語音辨識模組DFRobot原廠. 該模組採用了全新的離線語音識別晶片。內置135條常用的固定命令詞條,新增命令詞自學習功能,自製學習的 ... 於 www.taiwaniot.com.tw -

#39.「語音合成」在職進修、線上學習、共學教室

提供豐富的「語音合成」學習資源,您可以在此觀課教學與文章、進行測驗、加入共學 ... 接下來連續四天的今日頭條知識,我們給大家一瞥我們正在企畫中的教大家DIY自製 ... 於 nabi.104.com.tw -

#40.小試OpenAI Whisper 語音轉文字

OpenAI Whisper 有五種模型大小,大模型精準度較高,但耗用資源多,處理速度慢。除了最大模型之外,另外有英語專用模型,提供更好的識別率。 Whisper 支援 ... 於 blog.darkthread.net -

#41.Buzz,使用OpenAI Whisper神經網路,正確率高

Whisper系統所提供的自動語音辨識(Automatic Speech Recognition,ASR)模型是被訓練來執行語音辨識與翻譯任務的,它們能將各種語言的語音變成文字,也能將這些文字 ... 於 jdev.tw -

#42.言語辨識及語音文字輸入HTML5 Web Speech Recognition ...

言語辨識及語音文字輸入HTML5 Web Speech Recognition API · Javascript ? 1. 2. 3. 4. 5. 6. 7. 8. 9. 10. 11. 12. 13. 14. 15. 16. 17. 18. 19. 20. 21. 於 hkgoldenmra.blogspot.com -

#43.聆聽iPhone 朗讀的螢幕內容、所選文字和輸入回饋

iPhone 還可在你輸入時提供回饋,並朗讀文字修正和建議。 更改朗讀設定. 前往「設定」 >「輔助使用」>「語音內容」。 調整 ... 於 support.apple.com -

#44.語音資料庫在地化威剛聲控機器人準確度高達九成(影) | 科技

威剛打造的AIoT 機器人,除了語音聲調是藉由Google 系統所提供以外,其餘包含雲端、語音辨識等等,全由威剛一手自製研發。 圖:朱泓任/攝. 於 newtalk.tw -

#45.護理交班情境之語音辨識技術__臺灣博碩士論文知識加值系統

對此,本研究首先自製中文之護理交班特定情境的語料庫:經由在台北醫院護理站實錄護理交班對談的語音資料,進行人工標註對應文字(Ground Truth)。 於 ndltd.ncl.edu.tw -

#46.AI人工智能(含AI 鏡頭、語音辨識...)

視訊鏡頭可辨識到臉部表情、舉手動作、錄製的聲音或任何你想要放在鏡頭前的 ... 2023/03/06 · AIQ智能語音聲控燈DIY幻彩燈組裝流程及實體延伸應用AIQ智能語音聲控燈DIY ... 於 www.oursteam.com.tw -

#47.語音錄放/辨識模組Voice Record /Play /Recognition Module

SFT-RD66 · SFT-RD66. 數位顯示FM收音機(DIY套件) · $499. ; HLK-V20 · HLK-V20. AI智慧語音識別控制模組 · $495. ; ADIO-MP3 · ADIO-MP3. Arduion mini MP3播放器模組 · $150. 於 shop.cpu.com.tw -

#48.Flag's 創客‧自造者工作坊超入門!AI 聲音姿態影像辨識大應用

AI 聲音姿態影像辨識大應用,語言:繁體中文,ISBN:4712946750883,頁數:88,出版社:旗標,作者:施威銘研究室, ... Lab00B 自製線上手語辨識練習系統 於 www.books.com.tw -

#49.AIoT人工智慧在物聯網的應用與商機(第二版)(電子書)

... 與影像辨識是很好的利基,還有 Siri 及 Google Assistant 的中文語音部分發展完備, ... 家庭產品更加便利;在行的部分,台灣的公共汽車為了環保而自製且電動化是趨勢, ... 於 books.google.com.tw -

#50.1吋大頭照只要8元。身份證、護照、駕照、立可得洗照片

【省錢教學】DIY洗證件照,快速自製2吋、1吋大頭照只要8元。 ... 特殊痣、胎記、疤痕等清晰、不遮蓋,相片不修改且不得使用合成相片,足資辨識人貌。 於 kikinote.net -

#51.audio loopback 基本的訪談逐字稿 - G0V@Hackpad

Firefox x Chrome) 但是Google語音辨識速度明顯比人講話慢。 ... Scott Tsai> 自製做法https://www.facebook.com/700484037/posts/10153115500289038; 若只有一個音源 ... 於 g0v.hackpad.tw -

#52.自然語言處理筆記

語音. Microsoft Speech Platform 有語音辨識及合成; (工研院)語音語言互動處理技術網 ... ReadSpeaker 付費服務,多種常見語言都有,中文語音可唸英文 ... 於 twilightzone.gitlab.io -

#53.App Inventor : SpeechRecognizer 語音辨識

最近要寫一個以語音發出指令,然後利用手機控制馬達的程式,現在MIT App Inventor 中的Media 就內建有 SpeechRecognizer 語音辨識的積木可以來構建我 ... 於 gsyan888.blogspot.com -

#54.Flag's創客.自造者工作坊: 超入門! AI聲音姿態影像辨識大應用

AI聲音姿態影像辨識大應用:內容介紹:實作AI的門檻已逐漸降低,也不再是專業研究 ... 產品目錄目錄: CH01 AI 影像辨識Lab00A 自製手語辨識器Lab00B 自製線上手語辨識 ... 於 www.eslite.com -

#55.台灣如何找到AI語音發展活路?

雖然國內AI界都同意自然語言處理(NLP)是台灣推動AI人機介面必須要仰賴的技術,但是最重要、最基礎的第一步,需要累積數據進行語音辨識訓練的部分, ... 於 www.bnext.com.tw -

#56.訊飛語音輸入法Windows 版,讓你的電腦也能跟上行動裝置 ...

甚至它還能辨識「閩南語」的語音,將它轉換成文字!(當然,正確率不像國語那麼好,且文字本身不是標準的閩南語文字,比較適合簡單溝通參考!). 於 harmonica80.blogspot.com -

#57.百度推出智慧語音助理「度秘」

百度的語音助理服務借鑑Google Now模式,整合在自家獨立搜尋App「手機百度」之中。加入了聲紋辨識登入模式,使用者語音驗證的錯誤率為千分一,能當作既有 ... 於 tw.yahoo.com -

#58.基於Sphinx之聲音控制以Raspberry+pi自走車為例

除了語音辨識的重要性,還得學會控制GPIO 來達到載具操控,結合無線遙控以樹莓派作為控制器主體的自製載具,經過PocketSphinx 聲音辨識系統的控制做出載具除了前進、 ... 於 www.airitilibrary.com -

#59.EZTalking化身AI助教開口說英語不怕丟臉

開口說一直是台灣人學習語言最大的障礙,然而口說訓練需要仰賴大量的師資人力,AI新創公司易晨智能透過AI 語音辨識演算法打造EZTalking為老師提供AI ... 於 ctee.com.tw -

#60.Top 100件語音識別diy - 2023年8月更新

ASR PRO語音識別模塊AI離線智能開發板diy串口一鍵下載遠超LD3320. 優惠促銷. ¥. 7.9. ¥10. 已售8件. 收藏. 5評價 · 語音控制智能垃圾桶識別播報人工智能分類 ... 於 world.taobao.com -

#61.語音辨識彙整- AI - 雨,RAIN

Google Teachable Machine 無程式碼建立AI 模型. by Rain Chu | 3 月17, 2022 | AI, Tool, 人臉辨識, 語音辨識. 還記得2013 年,我用圖形演算法寫了一個跟電視裡面 ... 於 rain.tips -

#62.自造故事:如何使Otto機器人進行語音辨識?

我們發現,在Seeed studio工作室的朋友有一個價格上可負擔且體積小的語音辨識模組,所以我們便與Seeed studio接洽,而他們也很喜歡這個點子,於是便以 ... 於 vmaker.tw -

#63.自製iPod touch的麥克風,啟用二代機的語音控制功能

語音 控制早就不是科幻產物了,筆者N年前買的Power Mac 6100/66AV,CPU是66MHz的PowerPC 601,如果我沒記錯的話,它是第一台內建語音識別功能的個人電腦。 於 swf.com.tw -

#64.語音辨識App 幫無喉者說話

團隊透過自製的特殊共振波,打入人體空腔內部來產生機械語音,再藉由語音辨識App與人工智慧技術轉譯成文字顯示於App上,藉此讓無喉者可以透過免手持的 ... 於 www.merit-times.com -

#65.APPINVENTOR教學-連續語音辨識 - 隔壁生科教室

語音辨識 是AI人工智慧主題的熱門應用之一,所以獨立成一篇。 若要從語音辨識開始做. 請匯入範例作業example5 到appinventor. 影片則請從第10 ... 於 nxtc.ymtech.education -

#67.自動語音識別(Automatic Speech Recognition) -- 觀念與實踐(續)

如果針對整段演講進行辨識,勢必要有一個較完整的架構,除了靠『語音信號處理』外,尚須借重『自然語音處理』去矯正辨識出來的結果,才能畢其功於一役,以下就是一個較完整 ... 於 ithelp.ithome.com.tw -

#68.益大資訊~AI 語音辨識:用Kaldi 實作應用全集

出版社:深智出版日期:2020年9月21日ISBN:9789865501525 定價:880元售價:660元有看部落格的才有此優惠喔也可到露天購買https://www.ru. 於 etaitbook08.pixnet.net -

#69.Google助理- 維基百科,自由的百科全書

同年11月,個人助理增加了辨識當前正在播放的歌曲功能。2018年7月,Google Home版本的個人助理加入了單個語音指令觸發的多個 ... 於 zh.wikipedia.org -

#70.Nvidia 新AI 語音合成技術,揮別Google 小姐實現真人聲發音

Nvidia 打破傳統生硬的機器語音技術,開放RAD-TTS 原始碼讓擬真人語音互動更多元。#趨勢,語音辨識,機器學習,NVIDIA, ... 於 www.inside.com.tw -

#71.聽障者視訊學習運用語音辨識軟體有訣竅 - 公視新聞網

就是利用語音辨識軟體,把老師說的話一個一個轉成文字。 許庭榮表示,碰到最大的問題是要怎麼把電腦播放的聲音,傳給雅婷這個程式轉成文字,研究 ... 於 news.pts.org.tw -

#73.以深度學習加速語音及影像辨識應用發展

以深度學習加速語音及影像辨識應用發展- Download as a PDF or view ... 廣告頻道商自製(耗時費力) 影音內容分析辨識n借助深度學習技術,自動分析影片 ... 於 www.slideshare.net -

#74.本期專訪|練光祐教授:量「聲」訂做智慧家庭聲控系統

另外也可對發音方位進行語音強化並弱化其他方位的噪音,提高音訊品質。 ... 研究室有許多自製的演算法,可用於語音辨識、語者辨識、深度學習等。 於 criep.ntut.edu.tw -

#75.如何自制一个超迷你的语音助手

其实还有一个更合理的原因,p-i-c-o的发音清脆,音节突出,语音唤醒的成功率会 ... 所以智能家居控制的大部分的功能可以直接移植过来使用,包括自制的物联网网关硬件。 於 zhuanlan.zhihu.com -

#76.今華電子材料零件網路商城 各類零組件、電腦耗材周邊、各類 ...

壓力/ 彎曲模組 · 杜邦線/ 配件 · 氣體感測模組 · 語音錄放/ 辨識/ 音效模組 · 開關模組 · 生醫模組 · 電壓/霍爾電流模組 · 實習套件/ 馬達/ 太陽能. 於 jin-hua.com.tw -

#77.NVIDIA Jarvis 簡化打造最先進對話式人工智慧服務的方式

位於麻州劍橋市S&P Global 創新中心的Kensho,部署了具擴充能力的機器學習和分析系統,並透過使用NVIDIA 的對話式AI 技術,開發出用於金融商業的語音辨識 ... 於 www.pcdiy.com.tw -

#78.【課程】Arduino 101 雲端實作坊, 自製語音控制藍牙APP

設計語音辨識APP,手機藍牙4.0無線互動的障礙物警報裝置。 學習基礎Python 程式語言,設計圖形化介面控制我的Arduino101。 結合雲端服務,將感測器的資料 ... 於 www.techbang.com -

#79.疫情停課期的救星!AI幫老師聽課文朗讀,還意外翻轉學生人生

學習吧-AI-陳逸文-語音辨識-線上教育-線上平台 學習吧策略總監陳逸文(前排)帶領團隊投入線上教育開發,最初從自製國文教材起家,如今不但有各式出版 ... 於 www.cw.com.tw -

#80.(自製) APP分享-- 語音記事本

自製 免費APP分享-- 語音記事本下載網址:https://goo.gl/2DZGdP- 可不須 ... 怕啟動後還要操作半天才能儲存,這個可以設定直接啟動語音辨識後儲存, ... 於 www.mobile01.com -

#81.使用「Hey Google」執行語音搜尋與操作- Android

按照提示設定Voice Match,這樣Google 助理就能在你說出「Ok Google」時辨識你的聲音。 提示:如果你希望當Android 手機或平板電腦處於鎖定狀態時,依然不用動手就能 ... 於 support.google.com -

#82.【DFRobot】Gravity I2C & UART離線語音辨識模組

模組自帶一個喇叭和外接喇叭的介面,能即時語音回饋識別結果。模組採用I2C和UART兩種通訊方式,Gravity介面,相容Arduino Uno、Arduino leonardo、Arduino MEGA、 ... 於 www.kodorobot.com -

#83.arduino 語音助理- 系列教程十:语音识别模块LD3320

微型數字錄放語音IC芯片模塊機芯diy錄音機錄音筆音樂賀卡小製作. ¥. 2.2. 已售25件. 4.8. 5評價. 離線語音識別模塊雙麥陣列麥克風聲控智納捷IY. 2人 ... 於 apuh.deepwatersagency.com -

#84.iCShop - 電子材料/模組/STEAM教具/開發板軍火庫

iCShop 針對108課綱研發CIRCUS Pi品牌STEAM教學教具,亦提供Arduino、樹莓派、micro:bit、LinkIt7697、ESP32、mBot、DoBot、學習套件、感測器及各 ... 於 www.icshop.com.tw -

#85.樹莓派WM8960音訊解碼模組智慧語音辨識雙麥克風 ...

樹莓派WM8960音訊解碼模組智慧語音辨識雙麥克風智慧音箱DIY W7-201225 [421044]. 商品編號:1-421044; 您的價:$:元您的價:會員可見; 為您省:$:會員可見元(會員可見 ... 於 www.buy360.com.tw -

#86.直播聲音辨識神器,AI 學習自動上特效及字卡

六指淵團隊之前就有推出過「綜藝字卡」、「綜藝素材」,沒時間自製字卡的朋友,可以直接購買匯入,有時間的話自己做也沒有不行,素材匯入後選擇「綠背景」 ... 於 ez3c.tw -

#87.Flag's 創客‧自造者工作坊超入門!AI 聲音姿態影像辨識大應用

本產品會帶領讀者使用Teachable Machine 服務一步步來建立自己的機器學習模型, 內容囊括『聲音辨識』、『姿態辨識』以及『影像辨識』三類, 完成模型後再匯入到我們已經準備 ... 於 www.flag.com.tw -

#88.Google Teachable Machine 聲音分類結合Linkit 7697

TM 目前提供了三種不同的AI應用,分別是影像分類專案(Image Project)、聲音辨識專案(Audio Project) 與身體姿態辨識專案(Pose Project),因此 ... 於 blog.cavedu.com -

#89.繁體中文版 - 電子學位論文服務- 淡江大學

除了語音辨識的重要性,還得學會控制GPIO 來達到載具操控,結合無線遙控以樹莓派作為控制器主體的自製載具,經過PocketSphinx 聲音辨識系統的控制做出載具除了前進、 ... 於 etds.lib.tku.edu.tw -

#90.Arduino.Taiwan | Google的語音辨識轉文字功能必須在https ...

Google的語音辨識轉文字功能必須在https下執行, 因此對ESP系列Server走http就難以直接應用! 但山不轉路轉, 暫時做到網頁語音輸入控制ESP執行指令! 於 www.facebook.com -

#91.10 個免費語音轉文字工具,支援中文提升多種文書工作效率

同樣的, Android 上也有Google 內建的語音輸入法,在中文辨識上同樣很準確,不過很可惜的是, Google 的語音輸入法目前在台灣繁體中文上,不支援輸入標點 ... 於 www.playpcesor.com -

#92.ai好好玩-2 在自己電腦上就能把各種語音轉文字的工具whisper

whisper也有多種識別模型可選擇,占用電腦資源越少的速度越快,但識別出的文字錯誤率會越高。 另外,whisper跟之前介紹過的所有ai工具一樣,如果你有一張 ... 於 lamb.tw -

#93.Arduino 聲控開關- 語音辨識 - 30sec studio - 痞客邦

Arduino 聲控開關-語音辨識這是聲控開關的第二部,上次用到的技術是利用Mic回饋的電壓,判斷拍手的動作. 進而去控制開關的動作. 這次的比較簡單, ... 於 thirtysec.pixnet.net -

#94.【自造DIARY】如何使用ROS 1.0 完成語音辨識功能

本篇文章將使用樹莓派與ReSpeaker 4-Mic Array for Raspberry Pi 來完成語音辨識的功能;並使用ROS 1.0 系統的多機通訊功能,操控遠端電腦的小烏龜。 於 makerpro.cc -

#95.電動滑板車語音辨識應用設計

本文研究主要是利用動態時軸校正方法來設計電動滑板車語音辨識應用,期使讓低收入戶 ... 以Images SI 公司語音訓練模組SR-07 及語音介面模組SRI-03,連接本實驗室自製. 於 cyc2012.dyu.edu.tw -

#96.簡易語音助理實做(SpeechRecognition +Word2vector - CW Lin

語音 助理是個可以對你用聲音所下達的指令做出回應的一個工具,現在最紅的大概是Siri(Apple)、Alexa(Amazon)、Google ... 於 peaceful0907.medium.com -

#97.IT|軟體|應用|語音辨識|即時說話口譯DIY-1 基本應用

IT|軟體|應用|語音辨識|即時說話口譯DIY-1 基本應用 ... 1. 樹莓派主板x 1(Raspberry Pi 3 Model B) ... gTTS(Google Text to Speech):這個模組提供 ... 於 agilego99.blogspot.com -

#98.吉哥的分享- ASR語音辨識指令積木

這個ASR是標準的I2C的裝置,因此這些積木適用於所有的7697、ESP8266、ESP32,以及Arduino。積木的位置位於「吉哥積木」→「模組」→「ASR語音辨識」選單內 ... 於 sites.google.com