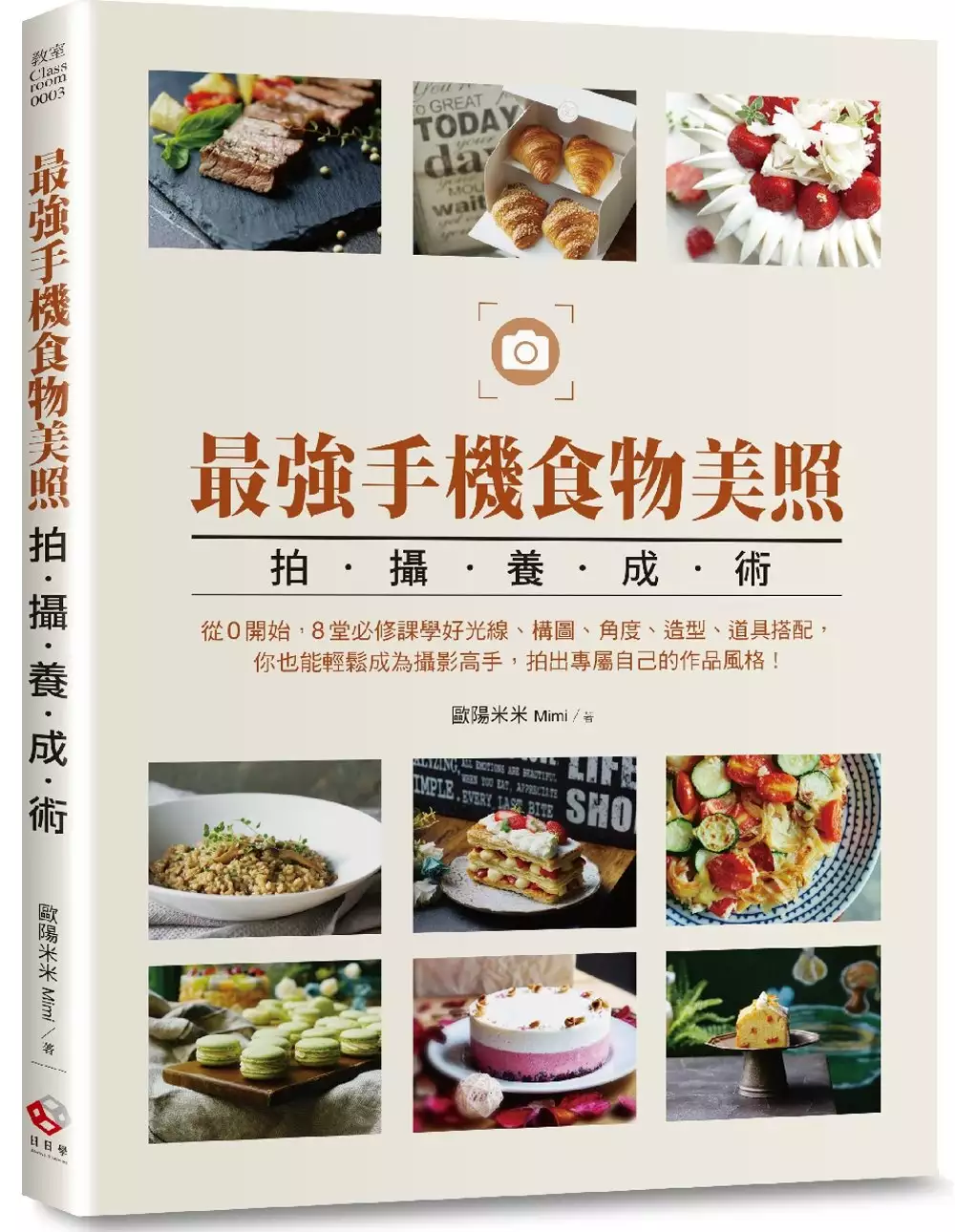

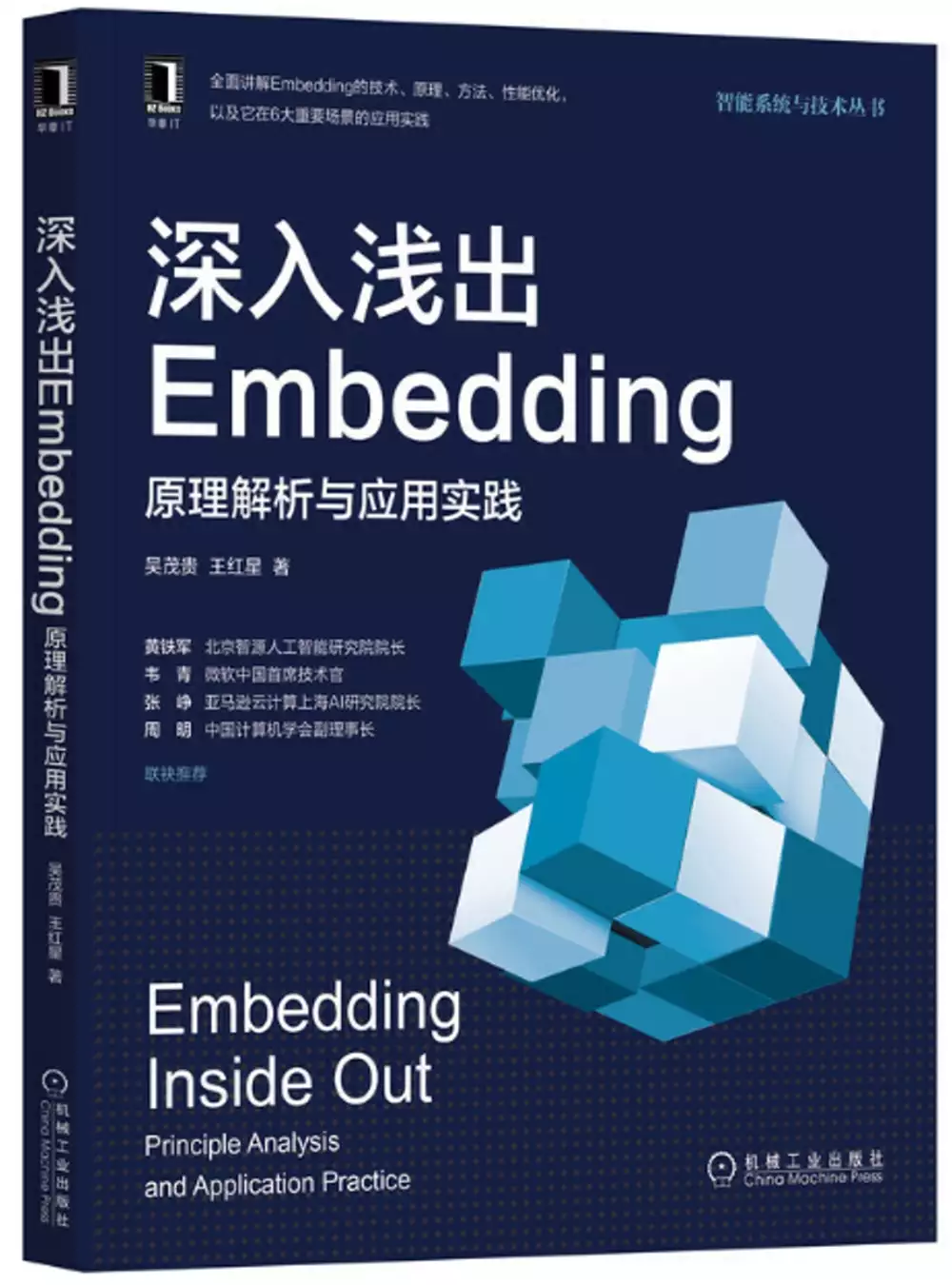

Bosch 產品的問題,我們搜遍了碩博士論文和台灣出版的書籍,推薦歐陽米米Mimi寫的 最強手機食物美照拍攝養成術:從0開始,8堂必修課學好光線、構圖、角度、造型、道具搭配,你也能輕鬆成為攝影高手,拍出專屬自己的作品風格! 和吳茂貴王紅星的 深入淺出Embedding:原理解析與應用實踐都 可以從中找到所需的評價。

另外網站小寶評測|20款車載凈化器大比拼(上):警惕臭氧風險也說明:我們購買了20件宣稱具備凈化顆粒物、凈化甲醛、凈化TVOC、除菌等性能的車載空氣凈化器產品,涉及PHILIPS、Haier、BOSCH、智米、TCL等品牌,價格從45.8元至 ...

這兩本書分別來自日日學 和機械工業所出版 。

國立宜蘭大學 生物技術與動物科學系動物科學碩士班 游玉祥所指導 張文瑜的 探討芽孢桿菌發酵物及精油對肉雞生長性能、腸道型態及盲腸菌相之影響 (2021),提出Bosch 產品關鍵因素是什麼,來自於肉雞、芽孢桿菌發酵物、精油。

而第二篇論文國立臺灣科技大學 資訊工程系 鮑興國所指導 Valentin Jules DE BALTHASAR DE GACHEO的 透過趨勢和差異分析、目標市場和價值主張定義、風險管理、原型設計和驗證以及以資料為中心的人工智慧方法;以有效的端到端程序,在產品和服務開發中實施人工智慧。 案例研究:無人機產業。 (2021),提出因為有 的重點而找出了 Bosch 產品的解答。

最後網站福士據報夥Bosch 拓車用軟件業務 - 信報則補充:投資者不應只按本網站內容進行投資。在作出任何投資決定前,投資者應考慮產品的特點、其本身的投資目標、可承受的風險程度及其他因素,並適當地尋求獨立的財務及專業意見。

最強手機食物美照拍攝養成術:從0開始,8堂必修課學好光線、構圖、角度、造型、道具搭配,你也能輕鬆成為攝影高手,拍出專屬自己的作品風格!

為了解決Bosch 產品 的問題,作者歐陽米米Mimi 這樣論述:

掌握基本要訣,學會8堂必修關鍵技巧課;手機也能隨手拍出吸睛的網美級照片,讓你立刻成為攝影達人! 這本書,集結了米米老師對各種類型飲食的深度了解,食材組合及特色上的專業知識,加上作者長久對於美學的涉獵與培養,將其重點精華融合,為手機拍攝整理出八個必修單元,且附有實例照片輔佐說明,將手機拍照會遇到的各種問題和迷思一一詳細解答;而其中的許多知識運用,除了不需設限手機廠牌,還可延伸至相機的拍攝概念。從基礎入門、概念、技巧到獨家拍攝懶人包,絕對超級實用! 「食物」永遠是最貼近我們生活的一個重要元素,也永遠是最受到群眾矚目的討論話題之一。 你,喜歡用

手機拍下當前令人垂涎的食物照嗎?不論是剛入門的手機拍照新手、想讓照片提升質感的攝影愛好者、需要快速拍出好看食物照的相關工作者,一張好看或極具創意的食物佳作,不僅能讓你的飲食記錄更加完美留存,也能讓你在社群平台上的大眾關注度提升;甚至,還有可能獲得意料之外的商業契機。 現在,就拿起手機,翻開這本書,跟著米米老師從美學培養、光線、構圖、角度、造型設計、道具運用,以及用照片說故事的情境營造等,一起探索並感受拍照的無窮樂趣吧。 本書特色 ★強調食物知識與手機拍照重要關聯性的第一本書。 ★獨家觀點剖析被疏忽的手機拍照技巧。 ★搶救攝影小白!手把手

教會你何時按下快門鍵。 ★最節省、超實用的食物美照拍攝養成術。 ★實際案例說明,秒解拍照盲點及關鍵思維。 ★掌握基本要訣,一拍就上手!讓具個人特色的美食照片打動人心。 各界一致推薦(依姓名筆畫排序) 周禎和─專業攝影師 班尼食夫─手繹生活 YouTube創辦人 陳文山─烘焙點子王53 許詠妡─義大利Politecnico米蘭大學附屬設計研究所{初見娜娜}繪畫工作室主理人 陳蘭怡─PoME概念體驗館 總擔任

Bosch 產品進入發燒排行的影片

全新馬達加上全新電池就是BITURBO全新性能的象徵,BOSCH GDS 18V-1050H首支1050Nm的衝擊扳手,這次也會實驗舊款電池跟新款電池的性能到底有沒有差異? 只有8.0以上的電池才能發揮全部性能你相信嗎?

台灣博世電動工具

https://www.bosch-pt.com.tw/tw/zh/

台灣博世年底多項兌換活動

https://bosch-pt.promote.tw/cordless_mtgb_5

#bosch18V#安全科技#台灣博世#BITURBO

▼ 支持台灣設計製造或其他好產品 ▼

【職人工廠官方賣場】https://www.711l.co/

【職人工廠蝦皮賣場】https://shopee.tw/shop/14732572/search

【職人工廠FB】https://www.facebook.com/TezJustMake/

合作提案請洽[email protected]

▼ 不可錯過的工具新品 ▼

來自台灣的世界最小扭力組合!日常維修必備精品!SLOKY x 職人工廠

https://youtu.be/IjoC1RALyNc

棒棒糖也能做成工具?職人工廠設計一款不得了的工具了!?棒棒糖手工具

https://youtu.be/LkK28Y40fb8

2021年砂輪機未來新趨勢!從未體驗過的快速更換砂輪片系統!

https://youtu.be/GHSjMY-rbA8

探討芽孢桿菌發酵物及精油對肉雞生長性能、腸道型態及盲腸菌相之影響

為了解決Bosch 產品 的問題,作者張文瑜 這樣論述:

肉雞養殖產業常面臨病原菌威脅、飼養空間限制、環境溫度過高及飼料汙染的挑戰,台灣飼料汙染又屬嘔吐毒素最為嚴重。在過去會以添加抗生素和傳統吸附劑來解決這些問題,然而抗生素會造成抗藥性細菌產生、殘留在食物中和環境汙染等問題,因此各國開始禁用抗生素;而傳統吸附劑的吸附能力不佳,並且有吸附飼料中微量元素的疑慮,需要另尋飼料添加物應對。精油對於肉雞擁有提升消化酵素、調節腸道菌群、抗氧化和免疫調節的功能;而芽孢桿菌發酵物在艱困環境中可形成孢子,更順利的到達腸道中定殖,且能分泌有抗菌能力的次級代謝物,在肉雞體內可調節細胞激素和腸道菌群,因此本實驗以精油與芽孢桿菌發酵物綜合添加,探討其對於肉雞生長性能、腸道型

態及盲腸菌相的影響。在體外抑菌試驗中,精油的添加對於枯草芽孢桿菌和地衣芽孢桿菌都無抑菌效果,適合綜合添加。而精油萃取液對於金黃色葡萄球菌和大腸桿菌都具有抑菌效果。在動物實驗一,證實芽孢桿菌發酵物可提升Lactobacillus菌屬相對含量;精油與芽孢桿菌發酵物綜合添加,則可提升Eubacterium hallii group和Christensenellaceae R 7 group菌屬相對含量,使其代謝物短鏈脂肪酸含量增加。精油則是透過提升抗氧化酶含量,來改善腸道絨毛型態。在動物實驗二,5 ppm嘔吐毒素攻毒模式下,精油與芽孢桿菌發酵物綜合添加可改善十二指腸段的絨毛高度與隱窩深度比值和顯著提

升空腸絨毛高度,並且提升菌群:Ruminococcaceae UCG 005、Ruminococcaceae UCG 014及Christensenellaceae R 7 group的相對含量,進而增加三甲基丁酸含量。產品吸附劑、降解劑及精油與芽孢桿菌發酵物綜合添加都可差異性調節促炎激素、抗氧化酶及緊密連接蛋白相關基因表現量。然而,只有精油與芽孢桿菌發酵物可提升肉雞血清中IFN-γ含量,使其與對照組無異。綜合上述,精油與芽孢桿菌發酵物的綜合添加,有能力調節腸道菌群及短鏈脂肪酸含量,進而改善腸道型態、促炎激素、抗氧化酶以及緊密連接蛋白相關基因表現量,具有取代抗生素的能力,且改善嘔吐毒素攻毒所造

成的負面影響。

深入淺出Embedding:原理解析與應用實踐

為了解決Bosch 產品 的問題,作者吳茂貴王紅星 這樣論述:

這是一本系統、全面、理論與實踐相結合的Embedding技術指南,由資深的AI技術專家和高級資料科學家撰寫,得到了黃鐵軍、韋青、張崢、周明等中國人工智慧領域的領軍人物的一致好評和推薦。 在內容方面,本書理論與實操兼顧,一方面系統講解了Embedding的基礎、技術、原理、方法和性能優化,一方面詳細列舉和分析了Embedding在機器學習性能提升、中英文翻譯、推薦系統等6個重要場景的應用實踐;在寫作方式上,秉承複雜問題簡單化的原則,儘量避免複雜的數學公式,儘量採用視覺化的表達方式,旨在降低本書的學習門檻,讓讀者能看得完、學得會。 全書一共16章,分為兩個部分: 第1部分(第1~9章)Em

bedding理論知識 主要講解Embedding的基礎知識、原理以及如何讓Embedding落地的相關技術,如TensorFlow和PyTorch中的Embedding層、CNN演算法、RNN演算法、遷移學習方法等,重點介紹了Transformer和基於它的GPT、BERT預訓練模型及BERT的多種改進版本等。 第二部分(第10 ~16章)Embedding應用實例 通過6個實例介紹了Embedding及相關技術的實際應用,包括如何使用Embedding提升傳統機器學習性,如何把Embedding技術應用到推薦系統中,如何使用Embedding技術提升NLP模型的性能等。

吳茂貴 資深大資料和人工智慧技術專家,在BI、資料採擷與分析、資料倉庫、機器學習等領域工作超過20年。在基於Spark、TensorFlow、PyTorch、Keras等的機器學習和深度學習方面有大量的工程實踐實踐,對Embedding有深入研究。 著有《深度實踐Spark機器學習》《Python深度學習:基於TensorFlow》《Python深度學習:基於Pytorch》等多部著作,廣受讀者好評。 王紅星 高級資料科學家,任職于博世(中國)投資有限公司蘇州分公司,負責BOSCH資料湖,資料分析與人工智慧相關的產品與服務的設計和開發。在大資料、機器學習、人工智慧方面有豐富的實踐經

驗。 前言 第一部分 Embedding基礎知識 第1章 萬物皆可嵌入2 1.1 處理序列問題的一般步驟3 1.2 Word Embedding4 1.2.1 word2vec之前4 1.2.2 CBOW模型5 1.2.3 Skip-Gram模型6 1.2.4 視覺化Skip-Gram模型實現過程8 1.2.5 Hierarchical Softmax優化14 1.2.6 Negative Sampling優化15 1.3 Item Embedding16 1.3.1 微軟推薦系統使用Item Embedding16 1.3.2 Airbnb推薦系統使用Item Embed

ding17 1.4 用Embedding處理分類特徵17 1.5 Graph Embedding20 1.5.1 DeepWalk方法21 1.5.2 LINE方法21 1.5.3 node2vec方法23 1.5.4 Graph Embedding在阿裡的應用23 1.5.5 知識圖譜助力推薦系統實例26 1.6 Contextual Word Embedding26 1.6.1 多種預訓練模型概述27 1.6.2 多種預訓練模型的發展脈絡29 1.6.3 各種預訓練模型的優缺點29 1.6.4 常用預訓練模型30 1.6.5 Transformer的應用32 1.7 使用Word Emb

edding實現中文自動摘要35 1.7.1 背景說明35 1.7.2 預處理中文語料庫35 1.7.3 生成詞向量36 1.7.4 把文檔的詞轉換為詞向量36 1.7.5 生成各主題的關鍵字38 1.7.6 查看運行結果39 1.8 小結40 第2章 獲取Embedding的方法41 2.1 使用PyTorch的Embedding Layer41 2.1.1 語法格式41 2.1.2 簡單實例43 2.1.3 初始化44 2.2 使用TensorFlow 2.0的Embedding Layer45 2.2.1 語法格式45 2.2.2 簡單實例45 2.3 從預訓練模型獲取Embedding

47 2.3.1 背景說明47 2.3.2 下載IMDB資料集47 2.3.3 進行分詞47 2.3.4 下載並預處理GloVe詞嵌入48 2.3.5 構建模型49 2.3.6 訓練模型50 2.3.7 視覺化訓練結果50 2.3.8 不使用預訓練詞嵌入的情況51 2.4 小結53 第3章 電腦視覺處理54 3.1 卷積神經網路54 3.1.1 卷積網路的一般架構55 3.1.2 增加通道的魅力56 3.1.3 加深網路的動機57 3.1.4 殘差連接58 3.2 使用預訓練模型59 3.2.1 遷移學習簡介59 3.2.2 使用預訓練模型的方法60 3.3 獲取預訓練模型63 3.4 使用P

yTorch實現資料移轉實例64 3.4.1 特徵提取實例64 3.4.2 微調實例67 3.5 小結69 第4章 文本及序列處理70 4.1 迴圈網路的基本結構70 4.1.1 標準迴圈神經網路71 4.1.2 深度迴圈神經網路72 4.1.3 LSTM網路結構72 4.1.4 GRU網路結構73 4.1.5 雙向迴圈神經網路74 4.2 構建一些特殊模型75 4.2.1 Encoder-Decoder模型75 4.2.2 Seq2Seq模型77 4.3 小結77 第5章 注意力機制78 5.1 注意力機制概述78 5.1.1 兩種常見的注意力機制79 5.1.2 注意力機制的本質79 5.

2 帶注意力機制的Encoder-Decoder模型81 5.2.1 引入注意力機制81 5.2.2 計算注意力分配值83 5.2.3 使用PyTorch實現帶注意力機制的Encoder-Decoder模型85 5.3 視覺化Transformer88 5.3.1 Transformer的頂層設計89 5.3.2 Encoder與Decoder的輸入91 5.3.3 高併發長記憶的實現91 5.3.4 為加深Transformer網路層保駕護航的幾種方法98 5.3.5 如何自監督學習98 5.4 使用PyTorch實現Transformer101 5.4.1 Transformer背景介紹1

01 5.4.2 構建Encoder-Decoder模型101 5.4.3 構建Encoder102 5.4.4 構建Decoder105 5.4.5 構建MultiHeadedAttention107 5.4.6 構建前饋網路層109 5.4.7 預處理輸入資料109 5.4.8 構建完整網路112 5.4.9 訓練模型113 5.4.10 實現一個簡單實例117 5.5 Transformer-XL119 5.5.1 引入迴圈機制119 5.5.2 使用相對位置編碼121 5.5.3 Transformer-XL計算過程122 5.6 使用PyTorch構建Transformer-XL12

3 5.6.1 構建單個Head Attention123 5.6.2 構建MultiHeadAttention126 5.6.3 構建Decoder129 5.7 Reformer130 5.7.1 使用局部敏感雜湊130 5.7.2 使用可逆殘差網路131 5.8 小結132 第6章 從Word Embedding到ELMo133 6.1 從word2vec到ELMo133 6.2 視覺化ELMo原理134 6.2.1 字元編碼層135 6.2.2 雙向語言模型137 6.2.3 生成ELMo詞嵌入138 6.3 小結139 第7章 從ELMo到BERT和GPT140 7.1 ELMo的優

缺點140 7.2 視覺化BERT原理141 7.2.1 BERT的整體架構141 7.2.2 BERT的輸入143 7.2.3 遮罩語言模型144 7.2.4 預測下一個句子145 7.2.5 微調146 7.2.6 使用特徵提取方法147 7.3 使用PyTorch實現BERT148 7.3.1 BERTEmbedding類的代碼149 7.3.2 TransformerBlock類的代碼149 7.3.3 構建BERT的代碼150 7.4 視覺化GPT原理151 7.4.1 GPT簡介151 7.4.2 GPT的整體架構151 7.4.3 GPT的模型結構152 7.4.4 GPT-2的

Multi-Head與BERT的Multi-Head之間的區別153 7.4.5 GPT-2的輸入153 7.4.6 GPT-2計算遮掩自注意力的詳細過程154 7.4.7 輸出156 7.4.8 GPT與GPT-2的異同156 7.5 GPT-3簡介157 7.6 小結160 第8章 BERT的優化方法161 8.1 視覺化XLNet原理162 8.1.1 排列語言模型簡介162 8.1.2 使用雙流自注意力機制163 8.1.3 融入Transformer-XL的理念164 8.1.4 改進後的效果164 8.2 ALBERT方法164 8.2.1 分解Vocabulary Embeddi

ng矩陣165 8.2.2 跨層共用參數167 8.2.3 用SOP代替NSP方法168 8.2.4 其他優化方法169 8.3 ELECTRA方法170 8.3.1 ELECTRA概述170 8.3.2 RTD結構171 8.3.3 損失函數171 8.3.4 ELECTRA與GAN的異同172 8.3.5 評估172 8.4 小結173 第9章 推薦系統174 9.1 推薦系統概述174 9.1.1 推薦系統的一般流程174 9.1.2 常用推薦演算法175 9.2 協同過濾176 9.2.1 基於用戶的協同過濾176 9.2.2 基於物品的協同過濾177 9.3 深度學習在推薦系統中的應

用178 9.3.1 協同過濾中與神經網路結合178 9.3.2 融入多層感知機的推薦系統179 9.3.3 融入卷積網路的推薦系統180 9.3.4 融入Transformer的推薦系統181 9.4 小結183 第二部分 Embedding應用實例 第10章 用Embedding表現分類特徵186 10.1 專案背景186 10.1.1 項目概述186 10.1.2 資料集說明187 10.2 TensorFlow 2詳細實現188 10.2.1 導入TensorFlow和其他庫188 10.2.2 導入資料集並創建dataframe188 10.2.3 將dataframe拆分為訓練、

驗證和測試集189 10.2.4 用tf.data創建輸入流水線189 10.2.5 TensorFlow提供的幾種處理特徵列的方法190 10.2.6 選擇特徵193 10.2.7 創建網路的輸入層194 10.2.8 創建、編譯和訓練模型194 10.2.9 視覺化訓練過程195 10.2.10 測試模型196 10.3 小結197 第11章 用Embedding提升機器學習性能198 11.1 項目概述198 11.1.1 資料集簡介199 11.1.2 導入數據200 11.1.3 預處理數據201 11.1.4 定義公共函數203 11.2 使用Embedding提升神經網路性能20

5 11.2.1 基於獨熱編碼的模型205 11.2.2 基於Embedding的模型207 11.3 構建XGBoost模型211 11.4 使用Embedding資料的XGBoost模型212 11.5 視覺化Embedding數據213 11.6 小結215 第12章 用Transformer實現英譯中216 12.1 TensorFlow 2+實例概述216 12.2 預處理數據217 12.2.1 下載數據217 12.2.2 分割數據219 12.2.3 創建英文語料字典220 12.2.4 創建中文語料字典222 12.2.5 定義編碼函數222 12.2.6 過濾數據223 1

2.2.7 創建訓練集和驗證集223 12.3 構建Transformer模型225 12.3.1 Transformer模型架構圖225 12.3.2 架構說明226 12.3.3 構建scaled_dot_product_attention模組226 12.3.4 構建MultiHeadAttention模組227 12.3.5 構建point_wise_feed_forward_network模組228 12.3.6 構建EncoderLayer模組228 12.3.7 構建Encoder模組229 12.3.8 構建DecoderLayer模組230 12.3.9 構建Decoder模

組231 12.3.10 構建Transformer模型232 12.3.11 定義遮罩函數233 12.4 定義損失函數236 12.5 定義優化器237 12.6 訓練模型239 12.6.1 產生實體Transformer239 12.6.2 設置checkpoint239 12.6.3 生成多種遮罩240 12.6.4 定義訓練模型函數240 12.6.5 訓練模型241 12.7 評估預測模型242 12.7.1 定義評估函數242 12.7.2 測試翻譯幾個簡單語句243 12.8 視覺化注意力權重243 12.9 小結245 第13章 Embedding技術在推薦系統中的應用24

6 13.1 Embedding在Airbnb推薦系統中的應用246 13.2 Transformer在阿裡推薦系統中的應用249 13.3 BERT在美團推薦系統中的應用250 13.4 小結253 第14章 用BERT實現中文語句分類254 14.1 背景說明254 14.1.1 查看中文BERT字典裡的一些資訊255 14.1.2 使用tokenizer分割中文語句256 14.2 視覺化BERT注意力權重256 14.2.1 BERT對MASK字的預測256 14.2.2 導入視覺化需要的庫257 14.2.3 視覺化258 14.3 用BERT預訓練模型微調下游任務259 14.3.

1 準備原始文本資料259 14.3.2 將原始文本轉換成BERT的輸入格式260 14.3.3 定義讀取資料的函數261 14.3.4 讀取資料並進行資料轉換263 14.3.5 增加一個批量維度264 14.3.6 查看一個批次數據樣例265 14.3.7 微調BERT完成下游任務265 14.3.8 查看微調後模型的結構266 14.4 訓練模型267 14.4.1 定義預測函數267 14.4.2 訓練模型268 14.5 測試模型269 14.5.1 用新資料測試模型269 14.5.2 比較微調前後的資料異同270 14.5.3 視覺化注意力權重271 14.6 小結272 第15

章 用GPT-2生成文本273 15.1 GPT-2概述273 15.2 用GPT-2生成新聞275 15.2.1 定義隨機選擇函數275 15.2.2 使用預訓練模型生成新聞275 15.3 微調GPT-2生成戲劇文本277 15.3.1 讀取文件277 15.3.2 對檔進行分詞277 15.3.3 把資料集轉換為可反覆運算對象278 15.3.4 訓練模型278 15.3.5 使用模型生成文本279 15.4 小結280 第16章 Embedding技術總結281 16.1 Embedding技術回顧281 16.1.1 Embedding表示281 16.1.2 多種學習Embeddi

ng表示的演算法282 16.1.3 幾種Embedding衍生技術283 16.1.4 Embedding技術的不足285 16.2 Embedding技術展望285 16.2.1 從Embedding的表示方面進行優化285 16.2.2 從Embedding的結構上進行優化286 16.3 小結286 附錄A 基於GPU的TensorFlow 2+、PyTorch 1+升級安裝287 附錄B 語言模型307

透過趨勢和差異分析、目標市場和價值主張定義、風險管理、原型設計和驗證以及以資料為中心的人工智慧方法;以有效的端到端程序,在產品和服務開發中實施人工智慧。 案例研究:無人機產業。

為了解決Bosch 產品 的問題,作者Valentin Jules DE BALTHASAR DE GACHEO 這樣論述:

Creating or enhancing products and services are one of the highest objectives and benefits of AI implementation in businesses, but this topic has not yet received much attention in the literature. This study presents a procedure to guide entrepreneurial, business, and research projects develop comp

etitive solutions integrating AI, more specifically deep supervised learning algorithms using unstructured data. The drone industry is selected as a case study. A transversal method that builds on the main trends and gaps identified in the adoption of AI in businesses is presented and implemented. T

he contribution of this study is threefold: First, the results indicate that the method maximized the chance of commercial success by identifying viable use cases, prevented wasting time and funds, decreased the risks of project’s failure, designed functionalities based on needs and competition, opt

imized data storage, increased model transparency and performance, and guide data collection. The author suggests that the procedure could be applied to other industries. Second, an overview of the drone industry cumulating market, literature and regulation reviews is provided and can guide future p

rojects. Third, the specifications of a drone design are provided and could help focus on the development of AI applications for drones.

Bosch 產品的網路口碑排行榜

-

#1.Bosch所有產品:手機,價格總覽與比較

探索所有Bosch最新產品,包含手機,一次比較空機、二手、維修價格,以及產品評價與推薦。 於 www.sogi.com.tw -

#2.勞勃·博世公司- 維基百科,自由的百科全書

博世的核心產品是汽車零部件(包括制軔器、控制器、電氣傳動、電子、燃料系統、發電機、起動機和轉向系統)、工業產品(包括驅動器和控制、包裝技術和消費品)和建築 ... 於 zh.wikipedia.org -

#3.小寶評測|20款車載凈化器大比拼(上):警惕臭氧風險

我們購買了20件宣稱具備凈化顆粒物、凈化甲醛、凈化TVOC、除菌等性能的車載空氣凈化器產品,涉及PHILIPS、Haier、BOSCH、智米、TCL等品牌,價格從45.8元至 ... 於 news.sina.com.tw -

#4.福士據報夥Bosch 拓車用軟件業務 - 信報

投資者不應只按本網站內容進行投資。在作出任何投資決定前,投資者應考慮產品的特點、其本身的投資目標、可承受的風險程度及其他因素,並適當地尋求獨立的財務及專業意見。 於 www2.hkej.com -

#5.購買ILLUMA 產品〉換Bosch高級廚房家電

於10月26日前憑已登記之萬寧Mann Card累積購買滿指定數量的ILLUMA® 產品(初生嬰兒奶粉除外),直接登入平台而無需發送收據,即可換領德國高級家電品牌Bosch ... 於 www.bigfamilyz.com -

#6.Bosch 線上教學影片

Bosch 家電小技巧-如何使用Bosch 洗碗機保養產品 · BoschHomeTW. BoschHomeTW ... Bosch 產品使用基本教學- 8系列複合式烤箱. 於 www.youtube.com -

#7.產品與服務 - 台灣博世

連接至交通產品與服務 ... 工業與商業. 博世為工業與商業領域提供創新產品和服務。 連接至工業與商業產品和 ... Robert Bosch Taiwan Co., Ltd. 2021.著作權之聲明. 於 www.bosch.com.tw -

#8.Bosch極致德國精湛工藝輕鬆快速完成米其林等年菜 - 中華日報

Bosch 人氣家電洗碗機推出「免費到府場勘」活動,專人評估產品安裝,貼心為用戶省去空間評估的煩惱。 · Bosch烤箱4D熱風加熱模式及烘培感應功能,春節年菜 ... 於 www.cdns.com.tw -

#9.BOSCH 博世,電動工具,修繕園藝 - MoMo購物

BOSCH 博世,電動工具,修繕園藝,居家輕裝修,精準測量,12V系列居家輕裝修,精準測量,12V系列各式規格種類,與BOSCH 博世熱門品牌,優惠便宜好價格,值得推薦! 於 www.momoshop.com.tw -

#10.BOSCH系列產品推薦、2021/12/10價格比較

BOSCH 系列產品價格比較 · BOSCH SDS plus-X5L 四溝五刃鎚鑽鑽頭3.4x50x110mm · BOSCH獨立式洗碗機13人份 · BOSCH 博世13人份獨立式洗碗機 · 博世GWS 12V-76 鋰電免碳刷圓切機 ... 於 www.shopback.com.tw -

#11.Bosch擴充氫燃料產品聯手OMB Saleri工程合作 - 中國時報

科技暨服務供應商博世(Bosch)正進一步擴充移動式氫燃料應用產品組合,已成功開發儲氫罐所需的氫罐閥門和減壓閥等零組件,博世與義大利專業廠商OMB ... 於 www.chinatimes.com -

#12.BOSCH 汽車用品 - 優立康股份有限公司

首頁 · 產品介紹; 汽車用品; BOSCH 汽車用品 ... 德國BOSCH歐系車專用軟骨雨刷-多接頭單支裝系列. 歐系車種 · 日美韓車種適用. 德國BOSCH新款V4亞熱帶雨刷系列. 於 www.unicornpro.com.tw -

#13.德國BOSCH - 瓦斯爐、洗碗機廚具專賣生活館

bosch 瓦斯爐康廚居家生活網秉持著優質的服務以及完美產品的品質精神,有著各大優秀品牌如林內、櫻花、喜特麗、豪山、和成、Amica、 BOSCH…等,瓦斯爐不會讓您失望。 於 www.home-life.tw -

#14.「Bosch」部分四英吋手提式平面砂輪機有過熱疑慮 - 經濟部 ...

標準檢驗局呼籲,使用前述生產期間之砂輪機的消費者應儘速至各地「博世(Bosch)」電動工具經銷商通路與販賣據點更換新品,以確保產品使用安全。本次「博世(Bosch)」 ... 於 www.bsmi.gov.tw -

#15.BOSCH – KeyLight - 奇萊科技

Bosch 工業經過一百多年的發展,在各行各業已成為知名的佼佼者,以其創新品質、多樣化產品而聞名。 博世在台提供的產品包含汽車原廠零件、汽車售後服務零件、傳動與 ... 於 www.keylight.com.tw -

#16.首頁| 台灣博世汽車售後零件

科技成就生活之美:我們希望我們的產品能點燃熱忱、提升生活品質並維護自然資源。 於 ap.boschaftermarket.com -

#17.BOSCH 所有产品目录和PDF技术手册

BOSCH 所有产品目录和PDF技术手册. Built-in Appliances 2020. 68 页. Freestanding Appliances 2020. 48 页. MBS533BW0B. 3 页. HBG6764B6B. 3 页. MBA5785S6B. 於 pdf.archiexpo.cn -

#18.BOSCH 博世品牌介紹| Costco 好市多

BOSCH 博世洗碗機,BOSCH博世洗衣機,BOSCH博世乾衣機,BOSCH博世冰箱等人氣商品盡在Costco ... 身為歐洲大家電領導品牌,BOSCH博世家電致力於生產出色的產品,BOSCH的精湛 ... 於 www.costco.com.tw -

#19.伯世登BOSCH博世電動工具網路專賣店 - PChome商店街

本公司專門進口德國[博世BOSCH 電動工具]以及[博世BOSCH 各類配件],。歡迎來電或來信洽詢任何有關於產品的問題。。為您服務是我們的榮幸謝謝-伯世登BOSCH博世電動工具 ... 於 www.pcstore.com.tw -

#20.博世電動工具

對我們的產品或服務有任何問題嗎? 請來郵件:. 電子郵件. 至頁面頂端. 版本说明 | 隐私政策 © Robert Bosch Taiwan Co., Ltd. 2017, all rights reserved. 隱私權設定. 於 www.bosch-pt.com.tw -

#21.福士據報夥Bosch 拓汽車軟件業務 - Now 財經

根據報道,福士將向合作項目投放數以億歐羅。 福士已經把旗下汽車軟件業務集中在分支Cariad,而後者成為福士行政總裁迪斯(Herbert Diess) ... 於 finance.now.com -

#22.Bosch Rexroth組裝技術產品 - 優弋捷自動化機械有限公司

Bosch Rexroth組裝技術產品. Bosch Rexroth組裝技術產品. Rexroth 油壓產品 ... 2021年博世電動手工具目錄Pro Pruner12V鋰電果樹剪枝機產品手冊簡易電動工具型錄配件 ... 於 www.yij.tw -

#23.產品展示-德國BOSCH 博世TasteWise 時尚歐美廚房家電館

tastewise時尚家電館經銷歐美進口家電,BOSCH 博世洗碗機滾筒式洗衣機烤箱崁入式冰箱,美國奇異GE 對開冰箱紅酒櫃,ASKO 賽寧洗碗機洗衣機,德國Miele 獨立式蒸爐洗碗機, ... 於 www.tastewise.com.tw -

#24.【研究報告】矽創(8016)轉型高毛利產品,訂單能見度高 - 理財寶

G-Sensor方面,由於大廠Bosch與STM將產能轉去生產高階陀螺儀(六軸),G-Sensor因此缺貨,昇佳順勢調整價格。公司2021年逐步排除產能瓶頸,隨著Sensor邁向 ... 於 www.cmoney.tw -

#25.附發票【新宇電動五金行】 浩克HULK 系列產品通用BOSCH ...

此產品只通用BOSCH博世18V系列產品並不通用浩克系列工具如要購買浩克18V系列通用電池請前往賣場搜尋正廠浩克HULK 鋰電池部分同行業者會盜用圖片,修改產品商標販售但 ... 於 shopee.tw -

#26.BOSCH內湖體驗中心的廚藝烹飪教室體驗,用科技廚具優雅的 ...

食材(一盒170g咖哩棒):; 作法:; BOSCH精湛萬用廚師機; BOSCH蒸烤爐. 湯咖哩燉肉. BOSCH蒸烤爐. 跟莉雅老師的合照; 更多BOSCH產品資訊. 廚師機:https://bit.ly/ ... 於 helloelise.com -

#27.BOSCH - 產品介紹| 沐華實業有限公司

華麗的系統配置、施工簡單 • 強大的對講功能、智能eHome • 電梯連動控制、立體式安全防護 • 個性化娛樂服務、溫馨生活服務. (觀看更多). NEW. 數位影視對講主機 ... 於 www.mmh.com.tw -

#28.Bosch 冰箱與洗碗機系出同門,源自道地德國設計| 大人物- 92304

建立在強大工業技術與對品質要求的嚴謹標準,「德國設計」、「德國製造」的產品,本身就自帶一種渾然天成的氣場,不論是哪種品類經常有個一致的特色,就是 ... 於 www.damanwoo.com -

#29.Bosch Group TW_Technical Buyer (ODM監控產品採購)

Legal Entity: Bosch Rexroth Co. Ltd. Company Description. Do you want beneficial technologies being shaped by your ideas? Whether in the areas of mobility ... 於 jobs.smartrecruiters.com -

#30.完成註冊後起算6個月內即可以#特殊優惠價購買Bosch原廠洗劑 ...

即日起至2021/12/31止,凡購買Bosch #洗碗機/ #洗衣機並至Bosch官網註冊產品,完成註冊後起算6個月內即可以#特殊優惠價購買Bosch原廠洗劑潔淨組合包✨ ... 於 tw.discount.wave-base.com -

#31.最新2021電鑽+bosch推薦~前13款高cp值電鑽+bosch報你知

【BOSCH 博世】12V鋰電震動電鑽/起子機鍍鈦配件套裝組GSB 12V-70 TiN ... 以上提供的圖片皆為示意圖,僅供參考,請依照實際產品規格為主。 於 panyi.cc -

#32.Bosch擴充氫燃料產品聯手OMB Saleri工程合作 - 工商時報

科技暨服務供應商博世(Bosch)正進一步擴充移動式氫燃料應用產品組合,已成功開發儲氫罐所需的氫罐閥門和減壓閥等零組件,博世與義大利專業廠商OMB ... 於 ctee.com.tw -

#33.BOSCH獨立式洗碗機比較表 - 甫佳電器部落格Fuchia blog

BOSCH 獨立式洗碗機,目前主要有七款機型。 ... BOSCH 洗碗機產品資訊https://www.fuchia.tw/v2/shop/index/1/1/1/2/2. **補充說明若以另一品牌ASKO洗 ... 於 blog.fuchia.tw -

#34.【參加心得】好家電讓做家事更easy!Bosch幸福家電體驗會分享

對於德國Bosch(博世)集團,大家最容易有印象的,就是Bosch生產的各式工具機產品。不過,Bosch集團橫跨的領域很廣,如果你是三立都會台「型男大主廚」節目的忠實觀眾 ... 於 hardaway.com.tw -

#35.Bosch Sensortec 產品– Mouser 臺灣

Bosch Sensortec 產品在Mouser Electronics有售。Mouser提供Bosch Sensortec 產品的庫存、價格和資料表。 於 www.mouser.tw -

#36.組裝技術產品| Bosch Rexroth 台灣

對工作環境進行個性化定製來滿足各自的生產要求,此時工作環境將更加高效。從鋁型材製成的週轉架和框架、隔斷、人體工程學組裝工作臺到全自動生產線與輸送系統:憑藉幾十年 ... 於 www.boschrexroth.com -

#37.BOSCH 品牌介紹 - 至晟貿易股份有限公司

BOSCH 品牌介紹. 說明. 德國汽車零部件與系統 博世汽車零組件: 最優良的汽車用品博世是全球最大的汽車零件供應商之一。全球的駕駛人以及專業技師對博世的產品和服務 ... 於 www.aresparts.com.tw -

#38.德產學界組大聯盟推行軟體定義製造計畫- DIGITIMES 智慧應用

由博世(Bosch)、斯圖加特大學(University of Stuttgart)、Karlsruhe理工 ... 可望促成汽車業的車款與產品更迭更加快速與多變,例如BMW採用NVIDIA的3D ... 於 www.digitimes.com.tw -

#39.BOSCH 產品一覽| FORTRESS豐澤

網上購買超過485件BOSCH產品, 瀏覽及比較不同型號, 價錢, 規格。FORTRESS 豐澤為您提供最新BOSCH的型號產品, 額外購買優惠, 快捷送貨服務, 貼心客戶服務, 安全購物。 於 www.fortress.com.hk -

#40.Bosch集團在臺營收創新高,摩托車ABS、售後市場表現卓越

全球知名的車輛零配件大廠Bosch博世集團於2018年5月11日舉行臺北年度記者 ... 電瓶與雨刷仍是Bosch 2017 年銷售業績最佳的產品,不過火星塞等其他部件 ... 於 motor.u-car.com.tw -

#41.GDS18V-EC-討論與特價商品-2021年12月

「gds18v-ec」商品搜尋結果共313 筆 · 德國BOSCH 博世GDS 18V-EC 300 ABR 18V鋰電免碳刷衝擊扳手機 · 德國BOSCH博世1/2"方頭轉1/4"六角接桿2608551110 GDS 18V-EC 18V-Li用. 於 feebee.com.tw -

#42.BOSCH|品牌介紹|台北忠孝館 - SOGO百貨

BOSCH 博世家電為您完美呈現德國工藝設計之美,我們的產品沒有花俏的外型-只有讓廚房躍身藝術空間的簡約設計及生活美學。 此品牌出現過的店別. 台北忠孝館8F 台北復興 ... 於 www.sogo.com.tw -

#43.BOSCH 8件組六角柄磁磚鑽頭組 - 太千五金有限公司

可整組放入BOSCH Pick n Click收納盒內. ... 太千產品料號:B34-00062 ... 六角柄設計適合搭配衝擊起子機使用,如BOSCH GDR/GDX系列增加使用的便利性,並可讓機器能量 ... 於 www.taichin-hardware.com -

#44.全球汽車科技領導品牌Bosch | | CARNEWS

然而本次要介紹的Bosch汽車科技及零件產品,除一般民眾所熟悉的雨刷外,尚有火星塞、電瓶、發電機及煞車系統等眾多零件產品,且對應車型除歐系車外,更 ... 於 carnews.com -

#45.產品介紹- 寶仕達科技--Bosch rexroth力士樂變頻器..明電舍變頻

Rexroth VFC 3610 & 5610專注於中國市場,VFC 3610是為小型機械類應用量身打造的增強型V/f變頻器,功率範圍0.4 ~ 22 kW,啟動轉矩可達1.5 Hz / 100 %和3 Hz / 150 ... 於 www.bosta.com.tw -

#46.智慧科技剖析與應用產品發展趨勢—虛擬實境、感測器、人工智慧、智慧製造

值得注意的是,3 家指標性廠商皆在氣體分析布局最多的專利件數,像是 Robert Bosch GMBH 達到 207 件專利、Denso 達到 216 件專利、Honeywell 達到 182 件專利, ... 於 books.google.com.tw -

#47.產品型錄| Bosch博世家電

烤箱、蒸爐、蒸烤爐、微波燒烤爐、咖啡機、暖盤機、爐具、排油煙機等產品介紹,您可點選按鈕快速連結不同產品以及產品特點、安裝方式、適用配件等等(各型號比較表請 ... 於 www.bosch-home.com.tw -

#48.德國BOSCH洗碗機洗衣機電烤箱電冰箱蒸烤爐

產品 型錄 / 德國BOSCH洗碗機洗衣機電烤箱電冰箱蒸烤爐. 德國百年家電領導品牌Bosch 博世家電- 全新嵌入式廚房家電系列. BSH 家電集團為世界三大家電製造商之一. 於 www.wdinter.com.tw -

#49.BOSCH 博世-品牌館 - 集雅社

BOSCH 博世. 伴您左右,直到永遠。我們的家電產品。 博世無法讓您的日常工作消失。但我們可以為您縮短時間。身為歐洲第一家電品牌,博世總不斷以出色的表現讓您的日常 ... 於 www.gseven.com.tw -

#50.Bosch博世SDS-max電鎚GSH 5 CE Professional - 產品介紹

Bosch 博世SDS-max電鎚GSH 5 CE Professional · 13 J的鎚擊力,提供同級產品中最高的材料去除率 · 8 m/s²的振動控制功能,即使在時間緊迫的應用中仍可進行流暢而便利的作業 ... 於 www.canhouse.com.tw -

#51.Bosch專業電動工具與配件 - Facebook

Bosch 電動工具小常識】#機身號碼購買Bosch電動工具後,要記得填寫保固卡, ... 因寄送過程所造成遺失、損壞等時,本活動單位不負擔賠償責任與產品保固、維修等事宜。 於 www.facebook.com -

#52.免費220V電源處理服務」,有洗碗機和洗衣機提供消費者選擇

歐洲家電領導品牌BOSCH,以德國工藝、雋永耐用及創新科技深植於消費者心中 ... 適用產品:「90天滿意保證」適用於指定洗碗機及洗衣機型號產品,「免費 ... 於 www.prettyma3c.com.tw -

#53.博西家用電器股份有限公司 - 104人力銀行

此外,創辦人Robert Bosch先生也積極投入教育與訓練,並承諾提倡青年文化與協助失家兒童等社會企業責任。博世家電會持續致力於提供高品質與完美科技的產品,讓生活更美好。 於 www.104.com.tw -

#54.博世工具DIY保修

對我們的產品或服務有任何問題嗎? 電子郵件. [email protected] ... 於 www.bosch-diy.com -

#55.Bosch BeConnected - Google Play 應用程式

博世集團的電動工具事業部是全球電動工具市場領導者,滿足從專業使用者到企業用戶的工具需求。核心成功方針,來自研發能力以及創新速度。至今博世電動工具正朝向數位 ... 於 play.google.com -

#56.車用半導體晶片當紅,Bosch 斥資11 億美元興建第2 座12 吋廠

不過,Bosch 表示,目前旗下的晶片產品包括ECU 微控制器晶片、壓力和環境溫度感測器等諸多種類的晶片中,其在製造方面也擁有超過1,000 項專利,因此對於 ... 於 technews.tw -

#57.Bosch用AI發揮工匠精神,CES上端出虛擬遮陽板 - 數位時代

【CES2020】用AI幫太空人工作!Bosch從地面攻上太空,端出4項匠人級產品 ... 雖然不生產車,在CES 2020的展前記者會中,Bosch從遮陽板、疲勞偵測到儀表版, ... 於 www.bnext.com.tw -

#58.Bosch - 24h 購物

PChome and PChome Online are trademarks of PChome Online Inc. 本網站產品已投保富邦產物產品責任保險$250,000,000元。 保險證號:0525字第21AML0003472號. 於 24h.pchome.com.tw -

#59.五金街獨家產品- 電動工具- Bosch 博世- 品牌

買架撐,就係咁簡單. 於 mall.builderhood.com -

#60.茂忠企業有限公司/ 產品詢價業務平台

Bosch 電動工具專區. | 共有產品26 筆/ 目前位於第1 頁- 共3 頁. BOSCH 高壓清洗機UA125 110V 1500W. 建議售價 NT$6,713. Bosch六角麻花鑽尾HSS-CO 3.0 2608577118. 於 www.m5.com.tw -

#61.Bosch 909 Dual 產品規格- ePrice 行動版

Bosch 909 Dual. 已下市. 產品規格. 上市資料. 廠牌. 型號. 上市日期. 建議售價. 目前售價. 網路系統. 主要系統. 4G. 5G. 雙卡雙待. CA. CA功能. 智慧系統. 作業系統. 於 www.eprice.com.tw -

#62.Bosch 博世工具

積高五金(Jaco Hardware)提供各類型五金工具及建材家居用品,務求為顧客搜羅全球各地高質素五金產品,以迎合顧客的需要。我們對五金產品有豐富見識,歡迎向我們查詢任何 ... 於 jacohardware.com -

#63.日月光與博世Bosch Sensortec共同開發先進微機電元件 - ASE ...

隨著物聯網與智慧世界的新興產品裝置的廣泛應用,感測器技術扮演不可或缺的角色,業界高度需要創新的IC封裝解決方案,以滿足高效能、效率與尺寸需求。身為 ... 於 ase.aseglobal.com -

#64.產品展示

產品 目錄. 博世智能建築科技擁有廣博的産品線,覆蓋視頻監控、防盜報警、門禁控制及管理、火災報警。專業音頻與會議系統可提供全系列涵蓋溝通、聲音與音樂的專業産品與 ... 於 commerce.boschsecurity.com -

#65.家樂福線上購物

Bosch 洗碗機 火鍋 六福皇宮 石墨烯 聖誕 紐力活 桂冠 統一ab 衛生紙 中衛 中衛口罩 當日限定hershey s 泡麵 暖暖包 米 保久乳 可口可樂. 當日配. 1小時到. 當日配服務. 於 online.carrefour.com.tw -

#66.大世科-Bosch監控系統

Bosch IP攝影機, BVMS視頻管理軟體, 全功能視頻錄製管理系統. ... Bosch產品分類 ... Bosch Video Management System. -完整的系統架構,確保作業持續不中斷。 於 www.etatung.com -

#67.Janet 露背代言!BOSCH 駐點美麗華還要搶攻物聯網市場

歐洲品牌博世集團(BOSCH)選在台北內湖美麗華商圈開了首間百貨旗艦門市,有別於其他百貨門市,這裏展示了蒸烤爐、洗碗機、冰箱等該集團全產品線產品 ... 於 www.ettoday.net -

#68.BWXY Compatible Replacement for Battery Bosch 2 607 001 ...

1 Product Specific 需要電池。 第一個有效日期, 11 月15, 2021. 製造商, BWXY. 保固與支援. 產品保固: ... 於 www.amazon.com -

#69.BOSCH|品牌介紹 | 健康跟著走

bosch sogo - 德國最大家電品牌BOSCH,結合現代與傳統的設計,每項產品不僅功能表現最佳,更結合時尚與流行的優雅風格,榮獲國際多項產品... 於 info.todohealth.com -

#70.「專訪」烘焙老師愛用的德式家電從廚房開啟便利家居!Bosch ...

博世(Robert Bosch)於1886 年創立的Bosch 博世家電對推廣節能、高效產品不遺餘力,並將不斷求新求變作為品牌主軸;嚴謹細節與時俱進精神,讓柯小姐大力 ... 於 decomyplace.com -

#71.媽媽樂最佳幫手Bosch博世洗碗機雍容高雅轉身變出各種料理也 ...

(好物推薦) MASA廚房X Bosch X finish 節省寶貴時間多陪陪孩子們吧! 收到德國知名品牌『Bosch』洗碗機與洗碗機專用洗劑『finish』邀請,鮮少參加產品體驗 ... 於 choyce.tw -

#72.德國BOSCH博世熱水器,Paloma 百樂滿,Rinnai 林內 ... - 百越興業

MC-195T-TR-REU-A3200WFP-TR專用-循環迴水主溫控器. 產品型號: MC-195T-TR. 建議售價: 7800元. 詳細介紹. BC系列-浴室專用. 產品型號: BC-140V-1TR. 建議售價: 6680元 ... 於 www.buyyes.com.tw -

#73.博世高層:歐洲汽車業過於依賴亞洲半導體 - 自由財經

... 車用晶片和電池成為汽車產業的重要零件之一,但歐洲相關產業佈局緩慢,德國車用零件供應商博世(Bosch)董事長Franz Fehrenbach認為, 於 ec.ltn.com.tw -

#74.各家攪拌機比較分享,+BOSCH精湛萬用廚師機開箱

BOSCH 廚師機果汁配件使用方法與蔬果汁、醬汁的食譜配方分享(VIP會員專區) ... 吸塵器之後,對BOSCH產品產生好感,才進而想要試試看BOSCH的攪拌機. 於 rosalinakitchen.pixnet.net -

#75.BOSCH。GBA2。24DSE, 其他, 其他- Carousell

喺Hong Kong,Hong Kong 買BOSCH。 ... 類似嘅產品 ... BOSCH GWS660 有線款4吋磨機$300 門市地址: 觀塘門市裕民坊凱匯商場1/F 1A1鋪(富力) 荃灣門市 ... 於 www.carousell.com.hk -

#76.博世::代理產線::品佳集團

BOSCH Logo. 製造廠商: 博世 ... http://www.bosch-sensortec.com. 產品類別. Accelerometer sensors , Gyroscope , Pressure sensors. 產線簡介; 聯絡窗口. 產線簡介. 於 www.wpgholdings.com -

#77.博世半导体 - Bosch Semiconductors

博世为汽车产品、工业制品、消费类以及物联网产品提供的产品和解决方案,助力您的企业更加成功。 Bosch Sensortec. 博世传感器. 於 www.bosch-semiconductors.com -

#78.融程電股東會釋出好消息獲德Bosch大單 - 聯合新聞網

融程電董事長呂谷清表示,公司目前75%營收來自品牌產品,主力的強固型平板已逐漸達到規模經濟,去年陸續接獲賓士車檢平板、Honeywell倉儲物流平板 ... 於 udn.com -

#79.BOSCH_產品介紹_洋洋實業

BOSCH 是具有百年以上的老品牌,是德國一家以工程和電子為首要業務的跨國公司,產品多元,羅伯特博世是BOSCH的創始人,他於1886年,在斯圖加特創立了「精密機械和電氣 ... 於 www.oceanictech.com.tw -

#80.市場報導: CES 2020:Bosch以AI切入連網智慧汽車和智慧家庭

參展廠商之一德國汽車零組件大廠Bosch(博世)也不缺席,主打結合人工智慧及安全性,將展出旗下的連網智慧汽車和智慧家庭產品。 CES 2020創新獎產品: ... 於 iknow.stpi.narl.org.tw -

#81.BOSCH:BOSCH,是德國最大的工業企業之一,從事汽車技術

中文名稱:羅伯特·博世有限公司; 外文名:bosch; 創建時間:1886年; 總部所在地:德國斯圖加特; 產品服務:精密機械及電氣工程的工廠; 員工人數:275,000名 ... 於 www.easyatm.com.tw -

#82.bosch - 人氣推薦- 電源產品- 2021年12月 - 露天拍賣

共有138個搜尋結果- 露天拍賣從價格、銷量、評價綜合考量,為您精選和bosch相關的商品. ... 電源產品. bosch ... GY-68 BMP180 新款BOSCH溫度氣壓傳感器模塊代替BMP085. 於 www.ruten.com.tw -

#83.Bosch 创下了100年的里程碑,并推出了全新的家庭产品

返回Bosch 创下了100年的里程碑,并推出了全新的家庭产品 · « 图库上一张 图库下一张». 返回顶部. 移动 桌面. 本站圖文除使用者發表外,屬AUTOMACHI版權所有, ... 於 www.automachi.com -

#84.德國品牌Bosch提昇消費者體驗以高規格打造台北旗艦體驗展示 ...

歐洲家電領導品牌Bosch博世家電為讓更多台灣的消費者體驗Bosch品牌價值,並讓消費者親自感受具德國工藝之美的Bosch全系列產品,... 於 tw.news.yahoo.com -

#85.BOSCH博世-2021型錄

BOSCH 博世-2021型錄. BOSCH 2021 (廚房家電|三機). 代碼dm-08. download. 商品己加入購物車. Faded Short Sleeve T-shirts. BOSCH博世-2021型錄. 於 www.cbk.tw -

#86.小寶評測|20款車載淨化器大比拼(下):甲醛淨化是智商稅

我們對18件宣稱具有顆粒物淨化性能的產品進行測試,其中6件樣品性能顯著,30分鐘淨化效率即達到90% ... 博世車用空氣淨化器AM101 BOSCH KJ18G—AM101. 於 read01.com -

#87.Bosch 蒸烤箱CSG656RB7 黑色

Import the Bosch Black Combi Steam oven CSG656RB7 direct from Europe at ... 此電器產品大約45cm 高, 請查看說明書、使用手冊或到Bosch 網站,以得知確實尺寸。 於 importappliances.tw -

#88.特力屋

BOSCH 650W插電式GSB 13RE德國震動電鑽附工具箱內贈100件配件組. $1,899. $2,990 · 38% Off. RYOBI 120BAR AJP-1410A 日本高壓清洗機機身輕巧超省水. 於 www.trplus.com.tw -

#89.據報福士汽車夥Bosch就汽車軟件合作快成事 - AASTOCKS.com

目前福士汽車已將所有軟件工作集中在Cariad,希望可挑戰Tesla(TSLA.US) 及Alphabet(GOOGL.US) 的地位。(mn/da)(美股為即時串流報價; OTC市場股票除外, ... 於 www.aastocks.com -

#90.2021 最新10 款熱門BOSCH 洗碗機專業推薦 - EZ 工程網

為你推薦最新熱門BOSCH 洗碗機品牌及型號,快速找到最適合自己的博世洗碗機。 ... 若還想看更多熱門的產品推薦,歡迎點選下方連結前往。 於 www.ezneering.com -

#91.Broadway Lifestyle 百老滙: 主頁

百老滙官方網上商店提供最新家庭電器、智能手機、電腦產品及美容產品等畀你揀,仲有限量產品預訂、折扣優惠、門市取貨、送貨服務及十天購物保障。立即登入網站揀選你 ... 於 www.broadwaylifestyle.com -

#92.Bosch 博世家電-品牌介紹丨建材百寶箱BuildBox

Bosch 工業經過一百多年的發展,在各行各業已成為知名的佼佼者,以其創新品質、多樣化產品而聞名。例如:汽車工業、電動工具、電熱科技、家電、通訊、自動化工業、包裝 ... 於 buildbox.tw -

#93.德國BOSCH冰箱- 品牌電冰箱- 產品專區- 元昌電器-經銷大金 ...

德國BOSCH冰箱 · 德國LIEBHERR 利勃冰箱 · 德國Blomerg博朗格冰箱 · MABE美寶冰箱 · GE奇異冰箱 · 菲雪品克冰箱 · HITACHI日立冰箱 · Panasonic國際牌冰箱 ... 於 www.ye888.com.tw -

#94.其他產品-進口家電—德國BOSCH博世-商品專區

商品專區-,防蟑廚具,台中防蟑廚具,東區防蟑廚具,台北防蟑廚具,五股防蟑廚具,桃園防蟑廚具,八德防蟑廚具,系統廚具,台中系統廚具,東區系統廚具,台北系統廚具, ... 於 www.q-ma.com.tw -

#95.Bosch 博世旗艦館【PChome24h購物】

網路家庭旗下PChome24h購物,攜手Bosch,於PChome24h購物設立Bosch品牌旗艦館,PChome24h購物取得原廠授權的直營網購平台,且享有全台24小時、台北巿6小時到貨服務。 於 www.pchomeec.tw